Come implementare un database Oracle 12c Release 2 Grid e RAC su RHEL 7.x

요약: Passaggi e immagini per agevolare l'implementazione di database Oracle 12c Release 2 Grid e RAC su RHEL 7.x

지침

1. Requisiti hardware e software

1.1. Requisiti hardware

- Oracle richiede almeno 8 GB di memoria fisica

- Lo spazio di swapping è proporzionale alla quantità di RAM assegnata al sistema

| RAM | Spazio di swapping |

| Tra 1,5 GB e 16 GB | Uguale alla dimensione della RAM |

| Più di 16 GB | 16 GB |

Se si abilita HugePages, è necessario dedurre la memoria assegnata a HugePages dalla RAM disponibile prima di calcolare lo spazio di swapping.

Se si abilita HugePages, è necessario dedurre la memoria assegnata a HugePages dalla RAM disponibile prima di calcolare lo spazio di swapping.

- La seguente tabella descrive lo spazio su disco richiesto per un'installazione di Oracle.

| Posizione di installazione software | Requisiti minimi di spazio su disco |

| Grid Infrastructure home | Almeno 8 GB di spazio su disco |

| Oracle Database home | Almeno 6,4 GB di spazio su disco |

| Spazio su disco di storage condiviso | Dimensioni del database e della Flashback Recovery Area |

- Dimensione dello spazio temporaneo (/tmp) di Oracle di almeno 1 GB

- Un monitor che supporti la risoluzione 1024x768 per visualizzare correttamente il programma di installazione Oracle Universal Installer (OUI)

1.2 Requisiti di rete

- Si consiglia di assicurarsi che ogni nodo contenga almeno tre schede di interfaccia di rete, di cui una per la rete pubblica e due per la rete privata, per garantire l'alta disponibilità del cluster Oracle RAC. Se si intende utilizzare la funzione Automatic Storage Management (ASM) nel cluster, è necessaria almeno una rete Oracle ASM. La rete ASM può condividere l'interfaccia di rete con una rete privata.

- I nomi delle interfacce pubbliche, private e ASM devono essere identici in tutti i nodi. Ad esempio, se si utilizza em1 come interfaccia pubblica sul nodo uno, tutti gli altri nodi richiedono em1 come interfaccia pubblica.

- Tutte le interfacce pubbliche per ciascun nodo devono essere in grado di comunicare con tutti i nodi all'interno del cluster.

- Tutte le interfacce private e ASM per ciascun nodo devono essere in grado di comunicare con tutti i nodi all'interno del cluster.

- Il nome host di ciascun nodo deve seguire lo standard RFC 952 (www.ietf.org/rfc/rfc952.txt). I nomi host comprendenti il carattere di sottolineatura ("_") non sono consentiti

1.3. Requisiti del sistema operativo

- Red Hat Enterprise Linux (RHEL) 7.x (kernel 3.10.0-693.el7.x86_64 o versioni successive)

1.3.1 Partizione del disco del sistema operativo

Di seguito sono riportate le voci dello schema di partizionamento del disco consigliate durante l'installazione di RHEL 7 utilizzando un file kickstart sulle unità HDD locali con almeno 1,2 TB di spazio disponibile:

part /boot --asprimary --fstype="xfs" --ondisk=sda --size=1024

part pv.1 --size=1 --grow --ondisk=sda --asprimary

volgroup rhel7 pv.1

logvol / --name=root --fstype=xfs --vgname=rhel7 --size=51200

logvol swap --fstype swap --name=swap --vgname=rhel7 --size=17408

logvol /home --name=home --fstype=xfs --vgname=rhel7 --size=51200

logvol /var --name=var --fstype=xfs --vgname=rhel7 --size=20480

logvol /opt --name=opt --fstype=xfs --vgname=rhel7 --size=20480

logvol /tmp --name=tmp --fstype=xfs --vgname=rhel7 --size=5120

logvol /u01 --name=u01 --fstype=xfs --vgname=rhel7 --size=1 --grow

2. Preparazione dei server per l'installazione di Oracle

Prima di installare Grid e il database, assicurarsi di installare i seguenti script di deployment di Dell EMC, che consentiranno di impostare l'ambiente per

l'installazione del database Oracle

2.1. Collegamento dei sistemi a Red Hat Network (RHN)/Unbreakable Linux Network (ULN) Repository

Tutti gli rpm prerequisiti devono essere installati prima di eseguire l'installazione di GRID/DB.

Passaggio 1:

- rhel-7-server-optional-rpms

- rhel-7.x

Configurazione di un repository yum locale per l'installazione automatica degli RPM di dipendenza per eseguire l'installazione di GRID/DB

- La configurazione consigliata consiste nel fornire i file su http utilizzando un server Apache (package name: httpd). In questa sezione viene descritto l'hosting dei file di repository da uno storage di file system locale. Sebbene esistano altre opzioni per l'hosting dei file di repository, non rientrano nel presente documento. Si consiglia vivamente di utilizzare lo storage di file system locale per la velocità e la semplicità di manutenzione.

mkdir /media/myISO

mount -o loop myISO.iso /media/myISO

- Per installare e configurare il daemon http, configurare il computer che ospiterà il repository perché tutti gli altri computer utilizzino l'immagine localmente l'immagine DVD. Creare il file /etc/yum.repos.d/local.repo e inserire:

[local]

name=Local Repository

baseurl=file:///media/myISO

gpgcheck=0

enabled=0

- Ora verrà installato il daemon di servizi Apache con il seguente comando, che consente di abilitare temporaneamente il repository locale per la risoluzione di dipendenza:

yum -y install httpd --enablerepo=local

- Per utilizzare Apache in modo da fornire il repository, copiare il contenuto del DVD in una directory Web pubblicata. Eseguire i comandi seguenti come comando root (assicurarsi di cambiare myISO con il nome del proprio ISO):

cp -R /media/myISO/* /var/www/html/myISO

- Questo passaggio è necessario solo se SELinux è in esecuzione sul server che ospita il repository. Il comando seguente deve essere eseguito come root e ripristinerà il contesto SELinux appropriato per i file copiati:

- L'ultimo passaggio consiste nell'acquisire il nome DNS o l'indirizzo IP del server che ospita il repository. Il nome DNS o l'indirizzo IP del server di hosting verrà usato per configurare il file repo repository yum nel server client. Di seguito viene riportato l'elenco di una configurazione di esempio che utilizza il supporto di RHEL 7.x Server e si trova nel file di configurazione:/etc/yum.repos.d/myRepo.repo

[myRepo]

name=RHEL 7.x Base ISO DVD

baseurl= http://reposerver.mydomain.com/myISO

enabled=1

gpgcheck=0

- Installare manualmente il file compat-libstdc++ rpm utilizzando il comando rpm o yum nella directory in cui sono stati copiati gli rpm.

Es: rpm -ivh

yum localinstall -y

Passaggio 3:

- Installare gli rpm compat-libstdcc++ eseguendo il comando seguente

yum install –y compat-libstdc++.i686

yum install –y compat-libstdc++.x86_64

- Scaricare/copiare gli rpm forniti da DELL passando a RPM di deployment Dell Oracle per Oracle 12Cr2 su RHEL7.x (in inglese) per RH nei server in cui verranno eseguite le installazioni Grid/DB. Di seguito è riportato l'elenco degli RPM. Scaricare solo gli RPM necessari.

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm è progettato per effettuare le seguenti operazioni:

- Disabilitare transparent_hugepages in grub2.cfg

- Disabilitare numa in grub2.cfg

- Creare file oinstall e dba per gruppi e utenti Oracle

- Impostare parametri del kernel sysctl

- Impostare i limiti utente (nofile, nproc, stack) per gli utenti Oracle

- Impostare NOZEROCONF=yes in /etc/sysconfig/network file

- Creare utenti grid e gruppi asmadmin, asmdba, asmoper, backupdba, dgdba, kmdba

- Impostare i limiti utente (nofile, nproc, stack) per gli utenti grid

- Impostare parametri del kernel sysctl

- Impostare RemoveIPC=no per verificare che i semafori impostati per gli utenti non vengano persi dopo la disconnessione dell'utente

- Installare questi due rpm

yum localinstall –y dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

2.2. Configurazione della rete

2.2.1. Rete pubblica

Per configurare la rete pubblica su ciascun nodo

- Accedere come root.

- Andare a /etc/sysconfig/network-scripts e modificare il file ifcfg-em #, dove # è il numero del dispositivo di rete.

NAME="Oracle Public"

DEVICE= "em1"

ONBOOT=yes

TYPE= Ethernet

BOOTPROTO=static

IPADDR=<routable IP address>

NETMASK=<netmask>

GATEWAY=<gateway_IP_address>

- Impostare il nome host mediante il comando seguente

hostnamectl set-hostname <host-name>

dove <host-name> è il nome host che si sta utilizzando per l'installazione.

- Digitare service network restart per riavviare il servizio di rete.

- Digitare ifconfig per verificare che gli indirizzi IP siano impostati correttamente

- Per verificare la configurazione di rete, eseguire il ping di ogni indirizzo IP pubblico da un client sulla LAN che non fa parte del cluster.

- Connettersi a ciascun nodo per verificare che la rete pubblica funzioni. Digitare ssh per verificare che il comando Secure Shell (SSH) funzioni.

2.2.2 Rete privata

L'esempio riportato di seguito fornisce le istruzioni dettagliate per abilitare l'interconnessione ridondante tramite HAIP su una nuova installazione di Oracle 12c Grid Infrastructure.

- Modificare il file /etc/sysconfig/network-scripts/ifcfg-emX, dove X è il numero del dispositivo em; ifcfg-emX sono i file di configurazione delle schede di rete da utilizzare per l'interconnessione privata.

DEVICE=em2

BOOTPROTO=static

HWADDR=

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.140

NETMASK=255.255.255.0

DEVICE=em3

HWADDR=

BOOTPROTO=static

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.141

NETMASK=255.255.255.0

- Una volta salvati i file di configurazione, riavviare il servizio di rete utilizzando i comandi riportati di seguito.

nmcli connection reload

nmcli device disconnect em2

nmcli connection up em2

- Ripetere la procedura per ogni interfaccia che è stata modificata.

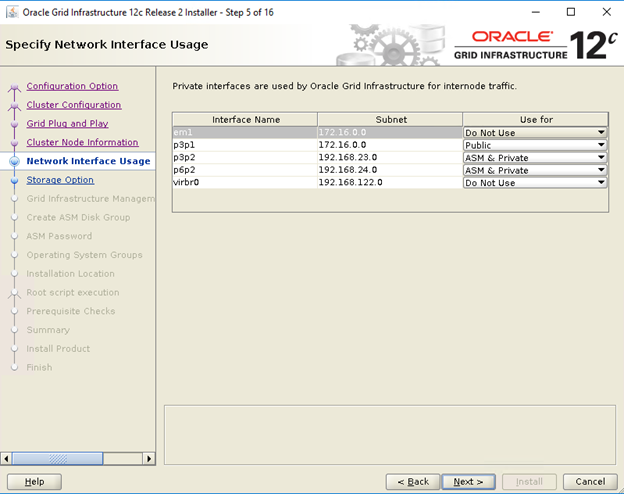

- Il completamento della procedura di cui sopra ha preparato il sistema per abilitare HAIP utilizzando il programma di installazione di Oracle Grid Infrastructure. Una volta completati tutti i prerequisiti Oracle e quando tutto è pronto per l'installazione di Oracle, sarà necessario selezionare em2 ed em3 come interfacce "private" nella schermata "Network Interface Usage".

- Questo passaggio abilita l'interconnettività ridondante quando Oracle Grid Infrastructure sarà completato e in esecuzione.

2.2.3 Rete Oracle Flex ASM

Oracle Flex ASM può utilizzare le stesse reti private di Oracle Clusterware o le proprie reti private dedicate. Ogni rete può essere classificata come PUBBLICA PRIVATA+ASM, PRIVATA o ASM.

2.2.4 Requisiti per l'indirizzo IP e la risoluzione dei nomi

È possibile configurare l'indirizzo IP dei nodi del cluster con una delle seguenti opzioni:

- Server dei nomi di dominio (DNS)

2.2.4.1. Server dei nomi di dominio (DNS)

Per configurare un Oracle 12c RAC tramite Oracle (senza GNS):

La tabella seguente descrive le diverse interfacce, le impostazioni degli indirizzi IP e le risoluzioni in un cluster.

|

Interfaccia

|

Tipo

|

Risoluzione

|

|

Pubblica

|

Statico

|

DNS

|

|

Privato

|

Statico

|

Non richiesto

|

|

ASM

|

Statico

|

Non richiesto

|

|

IP virtuale nodo

|

Statico

|

Non richiesto

|

|

IP virtuale SCAN

|

Statico

|

Non richiesto

|

Configurazione di un server DNS

Per configurare le modifiche su un server DNS per un cluster Oracle 12c con il DNS (senza GNS):

Configurare la risoluzione di SCAN NAME sul server DNS. Uno SCAN NAME configurato nel server DNS con la policy Round Robin deve essere risolto in tre indirizzi IP pubblici (consigliato); tuttavia il requisito minimo è di un indirizzo IP pubblico.

Esempio

scancluster IN A 192.0.2.1

IN A 192.0.2.2

IN A 192.0.2.3

dove scancluster è lo SCAN NAME fornito durante l'installazione di Oracle Grid.

Configurazione di un client di DNS

Per configurare le modifiche richieste sui nodi del cluster per la risoluzione dei nomi:

- È necessario configurare resolv.conf sui nodi del cluster in modo da contenere voci del server dei nomi che sia risolvibili nel server DNS.

nmcli connection modify ipv4.dns ipv4.dns-search

- Verificare la configurazione dell'ordine. /etc/nsswitch.conf controlla l'ordine del servizio dei nomi. In alcune configurazioni, il NIS può causare problemi con la risoluzione degli indirizzi SCAN di Oracle. Si consiglia di posizionare la voce NIS alla fine dell'elenco di ricerca.

Ad esempio, hosts: dns files nis

3. Preparazione dello storage condiviso per l'installazione di Oracle RAC

Oracle RAC richiede delle LUN per l'archiviazione dell'Oracle Cluster Registry (OCR), dei voting disk, dei file Oracle Database e della Flash Recovery Area (FRA). Nella tabella riportata di seguito viene illustrata la progettazione tipica del volume di storage consigliato per Oracle 12c Database.

| Tipo di volume del database/scopo | Numero di volumi | Dimensioni del volume |

| OCR/VOTE | 3 | 5 GB ciascuno |

| DATI | 4 | 250 GB1 ciascuno |

| REDO2 | 2 | Almeno 50 GB ciascuno |

| FRA | 1 | 100 GB3 |

| TEMP | 1 | 100 GB |

1 - Regolare ciascuna dimensione del volume in base al database; 2 - Si consiglia di disporre di almeno due gruppi di dischi REDO ASM, ciascuno con almeno un volume di storage; 3 - Idealmente, la dimensione dovrebbe essere 1,5 x le dimensioni del database se la capacità utilizzabile dello storage lo consente.

l'associazione persistente dei nomi sui nodi del cluster.

3.1. Configurazione del Device Mapper Multipath per lo storage XtremIO

Lo scopo del Device Mapper Multipath è consentire l'esecuzione di più percorsi di I/O per migliorare le prestazioni e garantire una denominazione coerente. La funzionalità multipath consente di raggiungere questi obiettivi combinando i percorsi I/O in un unico percorso device-mapper e bilanciando in modo appropriato il carico I/O. In questa sezione vengono indicate le best practice per configurare il multipath del mapper dei dispositivi all'interno del server Dell PowerEdge. Verificare che la versione del device-mapper e del driver multipath sia almeno quella mostrata di seguito o superiore:

- rpm -qa | grep device-mapper-multipath

device-mapper-multipath

- Abilitare il multipath mediante mpathconf –enable.

- Configurare il multipath XtremIO modificando /etc/multipath.conf con quanto segue:

device {

vendor XtremIO

product XtremApp

path_grouping_policy multibus

path_checker tur

path_selector "queue-length 0"

rr_min_io_rq 1

user_friendly_names yes

fast_io_fail_tmo 15

failback immediate

}

- Aggiungere nomi utente descrittivi appropriati a ciascun volume con l'scsi_id corrispondente. È possibile ottenere l'scsi_ids con il comando seguente:

/usr/lib/udev/scsi_id -g -u -d /dev/sdX

- Individuare la sezione multipath all'interno del file /etc/multipath.conf. In questa sezione è possibile fornire l'scsi_id di ciascun volume e fornire un alias per mantenere una convenzione di denominazione coerente in tutti i nodi. Di seguito viene mostrato un esempio:

multipaths {

multipath {

wwid <out put of step4 for volume1>

alias alias_of_volume1

}

multipath {

wwid <out put of step4 for volume2>

alias alias_of_volume2

}

}

- Riavviare il servizio daemon multipath con il comando seguente:

Service multipathd restart

- Verificare che l'alias dei volumi multipath sia visualizzato correttamente

multipath -ll

- Ripetere tutti i tre passaggi per tutti i nodi.

3.2 Partizionamento del disco condiviso

In questa sezione viene descritto come utilizzare l'utilità di partizione per creare un'unica partizione su un volume/disco virtuale che si estenda su tutto il disco.

Eseguire il partizionamento di ogni volume del database che è stato configurato con device-mapper con il comando seguente:

$> parted -s /dev/mapper/<volume1> mklabel msdos

$> parted -s /dev/mapper/<volume1> primary 2048s 100%

Ripetere l'operazione per tutti i volumi richiesti

-

Ripetere i passaggi precedenti per tutti i volumi e riavviare il multipathd su tutti gli altri nodi.

systemctl restart multipathd.service

-

Riavviare il sistema se la partizione appena creata non viene visualizzata correttamente.

3.3 Utilizzo delle regole di udev per le autorizzazioni e la persistenza del disco

Red Hat Enterprise Linux 7.x ha la capacità di utilizzare le regole di udev per assicurarsi che il sistema gestisca correttamente le autorizzazioni dei nodi del dispositivo. In questo caso, si fa riferimento alla corretta impostazione delle autorizzazioni per le LUN/i volumi rilevati dal sistema operativo. Notare che le regole di udev vengono eseguite in ordine enumerato. Quando si creano regole di udev per l'impostazione delle autorizzazioni, includere il prefisso 60- e aggiungere .rules alla fine del nome del file.

- Creare un file 60-oracle-asmdevices.rules in /etc/udev/rules.d

- Assicurarsi che ogni dispositivo a blocchi comprenda una voce nel file, come mostrato di seguito

#---------------------start udev rule contents ------------------------#

KERNEL=="dm-*", ENV =="C1_OCR1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA4p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_FRA?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_TEMP?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

- Eseguire "udevadm trigger" per applicare la regola.

- Copiare le regole di udev su tutti i nodi ed eseguire udevadm trigger per applicarle.

4. Installazione di Oracle 12c Grid Infrastructure per un cluster

4,1 Configurare le impostazioni del clock di sistema per tutti i nodi

Per evitare errori durante la procedura di installazione, configurare tutti i nodi con impostazioni del clock di sistema identiche. Sincronizzare il clock di sistema dei nodi con il Cluster Time Synchronization Service (CTSS) integrato in Oracle 12c. Per abilitare CTSS, disabilitare il servizio Network Time Protocol daemon (NTPd) del sistema operativo utilizzando i comandi seguenti nell'ordine indicato:

-

systemctl stop chronyd.service

-

systemctl disable chronyd.service

-

mv /etc/chrony.conf /etc/ntp.chrony.orig

I seguenti passaggi si riferiscono al nodo uno dell'ambiente cluster, se non diversamente specificato.

- Accedere come root.

- Se non si opera all'interno di un ambiente grafico, avviare il sistema X Window System digitando startx.

- Aprire una finestra del terminale e digitare xhost +.

- Montare il supporto Oracle Grid Infrastructure.

- Effettuare l'accesso come utente grid, ad esempio su -grid.

- Digitare il seguente comando per avviare il programma Oracle Universal Installer: /runInstaller

- Nella finestra Select Configuration Option, selezionare Configure Grid Infrastructure for a New Cluster, quindi cliccare su Next.

- Nella finestra Cluster Configuration, selezionare Configure an Oracle Standalone Cluster, quindi cliccare su Next.

- Nella finestra Grid Plug and Play Information, inserire le seguenti informazioni:

-

Cluster Name: inserire un nome per il cluster.

-

SCAN Name: inserire il nome registrato nel server DNS, univoco per l'intero cluster. Per ulteriori informazioni sulla configurazione di SCAN Name, vedere la sezione "Requisiti per l'indirizzo IP e la risoluzione dei nomi".

-

SCAN Port: mantenere la porta predefinita 1521.

-

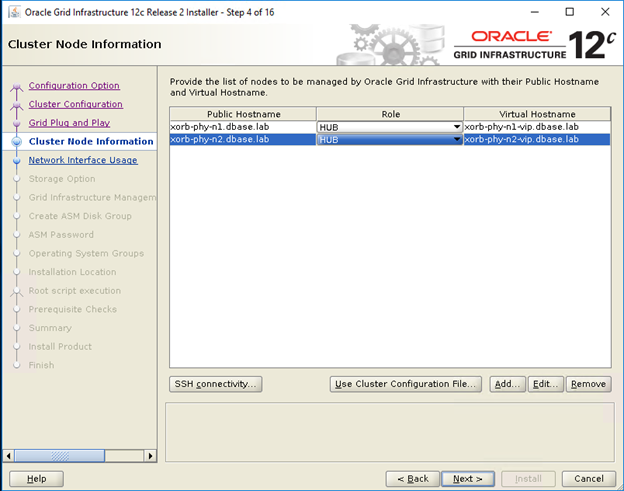

- Nella finestra Cluster Node Information, cliccare su Add per aggiungere ulteriori nodi da gestire con Oracle Grid Infrastructure.

- Inserire le informazioni relative al nome host pubblico per i nodi membri del cluster Hub e Leaf.

- Inserire il ruolo del nodo membro del cluster.

- Ripetere i 3 passaggi precedenti per ogni nodo del cluster.

- Cliccare su SSH connectivity e configurare la connettività SSH senza password inserendo la password del sistema operativo per l'utente grid, quindi cliccare su Setup.

- Cliccare su OK, quindi su Next per passare alla finestra successiva.

- Nella finestra Specify Network Interface Usage, verificare che siano selezionati i tipi di interfaccia corretti per i nomi di interfaccia. Nell'elenco a discesa "Use for", selezionare il tipo di interfaccia richiesto. Le opzioni disponibili sono Public, Private, ASM, ASM and Private. Cliccare su Avanti.

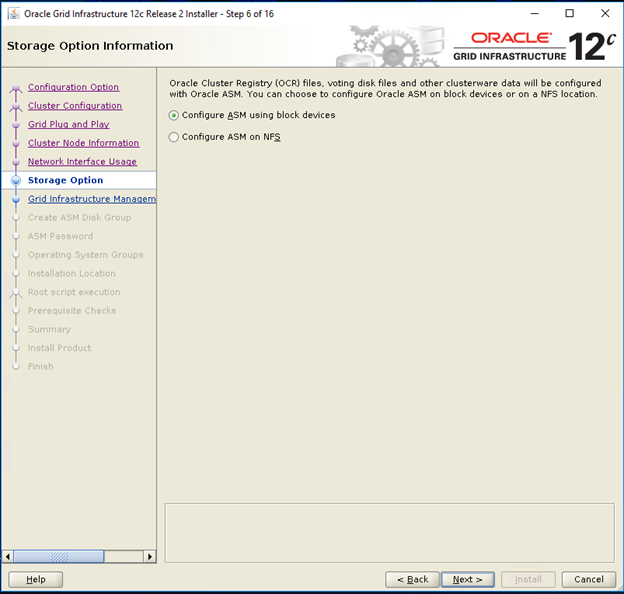

- Nella finestra Storage Option Information, selezionare Configure ASM using block devices, quindi cliccare su Next.

- Nella finestra Grid Infrastructure Management Repository Option, selezionare No per Configure Grid Infrastructure Management, quindi cliccare su Next.

- Nella finestra Create ASM Disk Group, inserire le seguenti informazioni:

-

Disk Group Name: inserire un nome, ad esempio OCR.

-

Redundancy: per i dischi OCR e i voting disk, selezionare High se sono disponibili cinque dischi ASM, selezionare Normal se sono disponibili tre dischi ASM oppure selezionare External se è disponibile un solo disco ASM (non consigliato).

-

- Nella finestra ASM Password, scegliere l'opzione pertinente in Specify the passwords for these accounts e inserire i relativi valori per la password. Cliccare su Avanti.

- Nella finestra Failure Isolation Support, selezionare Do Not use Intelligent Platform Management Interface (IPMI).

- Nella finestra Management Options, scegliere l'impostazione predefinita, quindi cliccare su Next.

- Nella finestra Privileged Operating Systems Groups, selezionare:

-

asmdba per Oracle ASM DBA (OSASM) Group

-

asmoper per Oracle ASM Operator (OSOPER) Group

-

asmdba per Oracle ASM Administrator (OSDBA) Group

-

- Nella finestra Specify Installation Location, specificare per Oracle Base e Software Location gli stessi valori configurati nell'RPM Dell Oracle utilities.

- Oracle Base: /u01/app/grid

- Software Location: /u01/app/12.1.0/grid_1

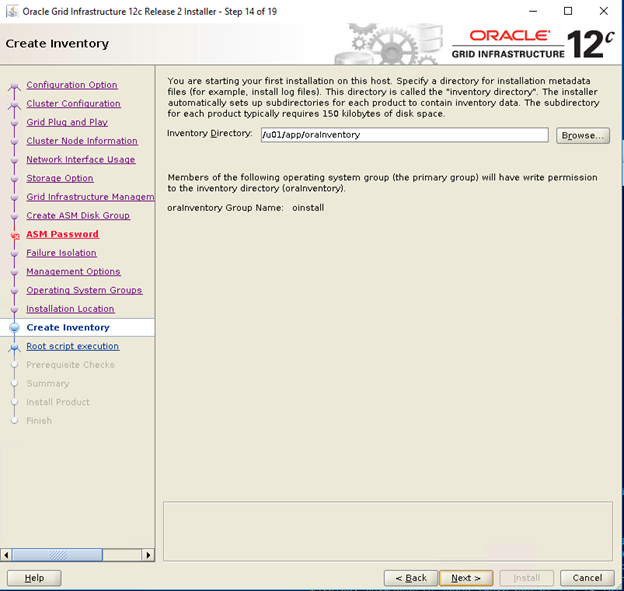

- Nella finestra Create Inventory, specificare la posizione della directory di inventario. Cliccare su Avanti.

La posizione predefinita basata sull'RPM Dell Oracle utilities per la directory di inventario è /u01/app/oraInventory.

La posizione predefinita basata sull'RPM Dell Oracle utilities per la directory di inventario è /u01/app/oraInventory.

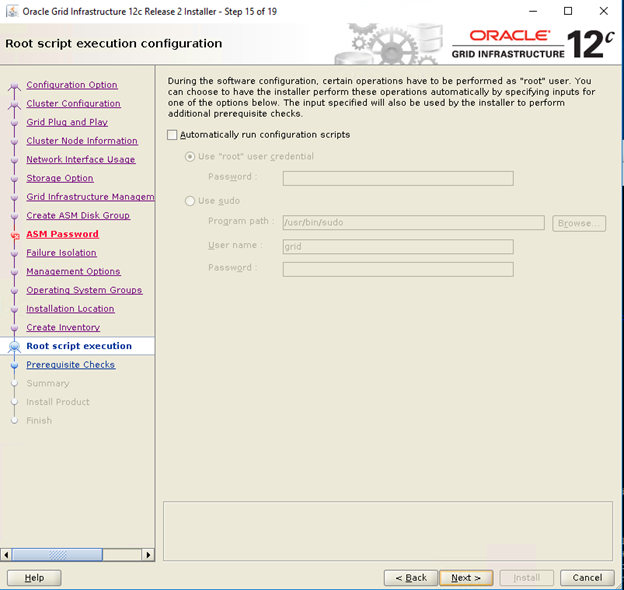

- Nella finestra Root script execution configuration, deselezionare l'opzione Automatically run configuration scripts, quindi cliccare su Next.

- Nella finestra Summary, verificare tutte le impostazioni, quindi selezionare Install.

- Nella finestra Install Product, controllare lo stato dell'installazione di Grid Infrastructure.

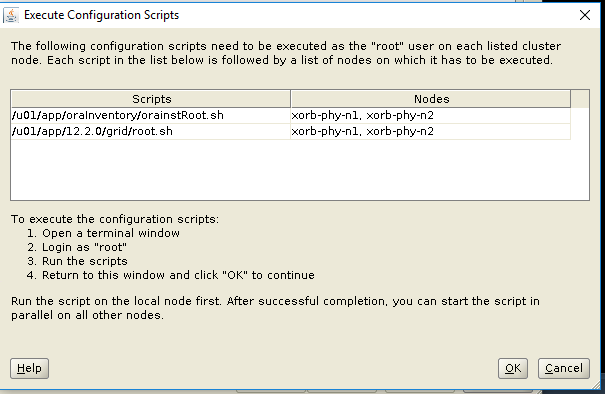

- Nella finestra Execute Configuration Scripts, eseguire gli script root.sh scripts su entrambi i nodi, quindi cliccare su OK.

- Nella finestra Finish, cliccare su Close.

5. Installazione di Oracle 12c Database

5.1 Installazione del software Oracle 12x Database (RDBMS)

I seguenti passaggi si riferiscono al nodo 1 dell'ambiente cluster, se non diversamente specificato.

- Effettuare l'accesso come utente root e digitare: xhost+.

- Montare il supporto Oracle Database 12c.

- Effettuare il login come utente Oracle digitando su - Oracle.

- Eseguire lo script del programma di installazione dal supporto Oracle Database:

<CD_mount>/runInstaller

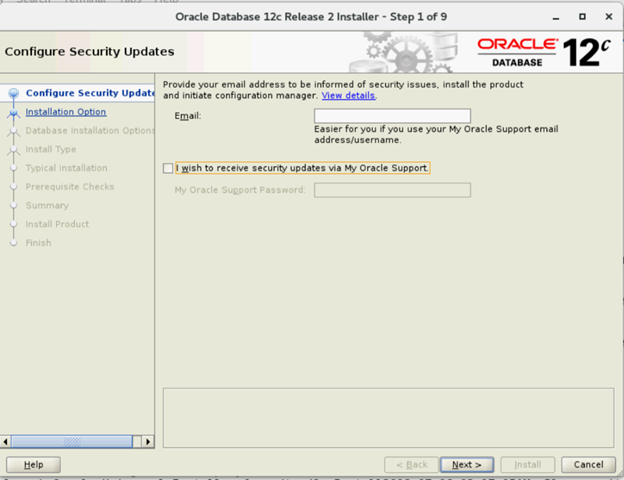

- Nella finestra Configure Security Updates, inserire le credenziali per My Oracle Support per ricevere gli aggiornamenti per la sicurezza, quindi cliccare su Next.

- Nella finestra Select Installation Option, selezionare Install database software only.

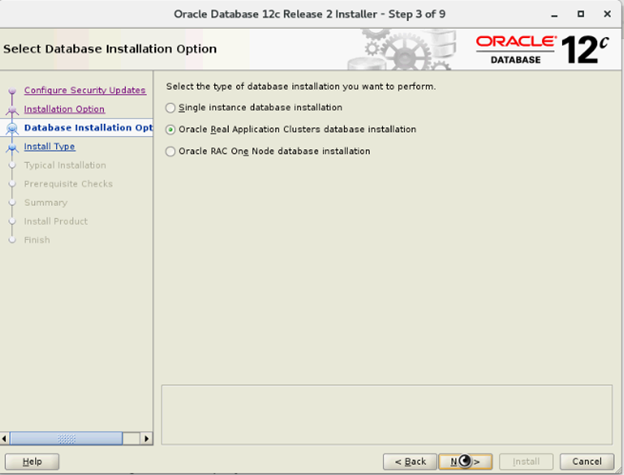

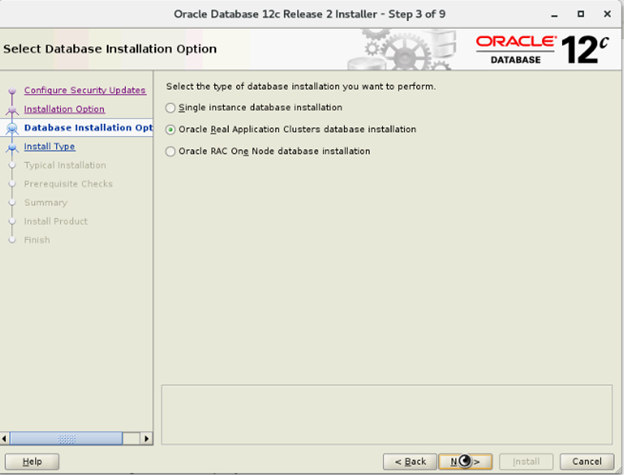

- Nella finestra Database Installation Options, selezionare Oracle Real Application Clusters database installation, quindi cliccare su Next.

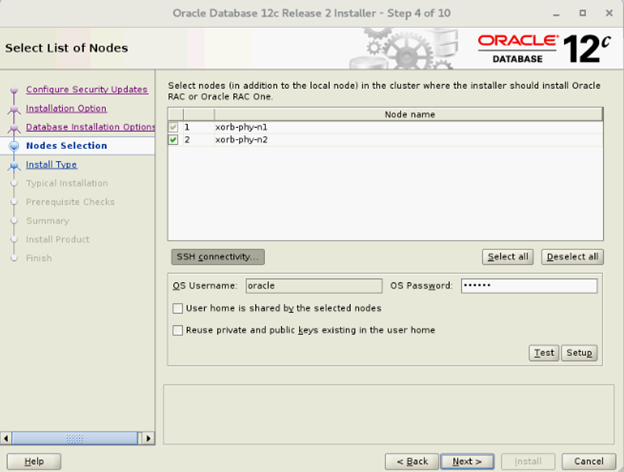

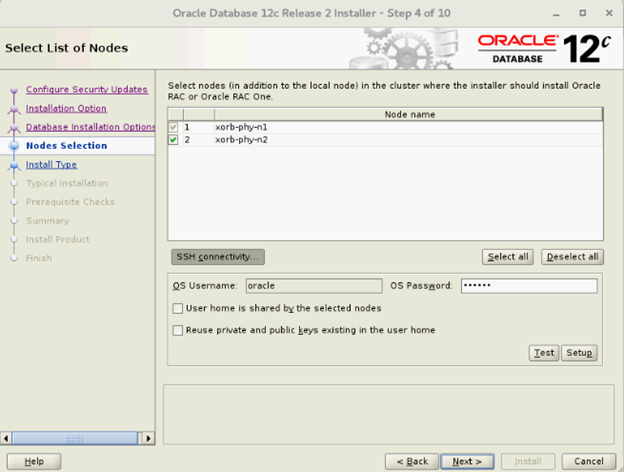

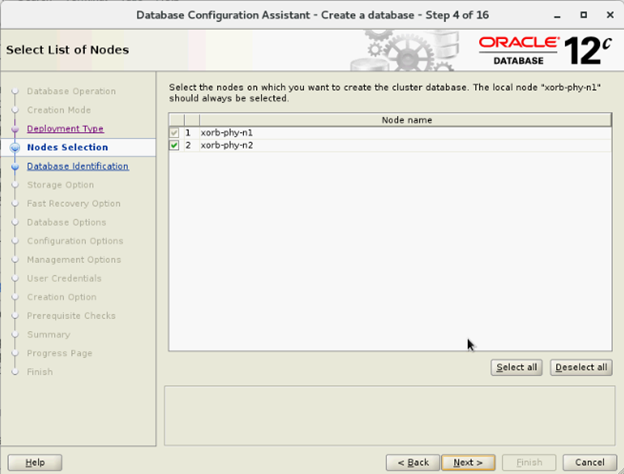

- Nella finestra Select List of Nodes, selezionare tutti i nodi Hub e omettere quelli Leaf, quindi cliccare su SSH Connectivity e configurare la connettività SSH senza password inserendo la password del sistema operativo per l'utente Oracle. Quindi selezionare Setup. Cliccare su OK, quindi su Next per passare alla finestra successiva.

- Nella finestra Database Installation Options, selezionare Oracle Real Application Clusters database installation, quindi cliccare su Next.

- Nella finestra Select List of Nodes, selezionare tutti i nodi Hub e omettere quelli Leaf, quindi cliccare su SSH Connectivity e configurare la connettività SSH senza password inserendo la password del sistema operativo per l'utente Oracle. Quindi selezionare Setup. Cliccare su OK, quindi su Next per passare alla finestra successiva.

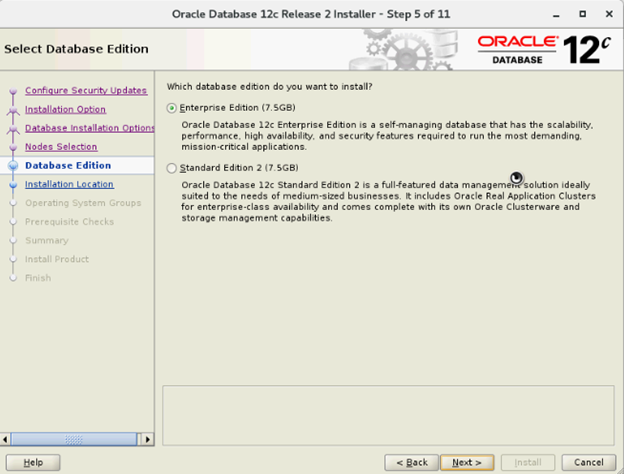

- Nella finestra Select Database Edition, selezionare Enterprise Edition e cliccare su Next.

- Nella finestra Specify Installation Location, specificare per Oracle Base la posizione configurata nell'RPM Dell Oracle utilities.

- Oracle base: /u01/app/oracle

- Software Location: /u01/app/oracle/product/12.1.0/dbhome_2

- Nella finestra Privileged Operating System Groups, selezionare dba per Database Administrator (OSDBA) group, dba per Database Operator (OSOPER) group, backupdba per Database Backup and Recovery (OSBACKUPDBA) group, dgdba per Data Guard administrative (OSDGDBA) group e kmdba per Encryption Key Management administrative (OSKMDBA) group, quindi cliccare su Next.

- Nella finestra Summary, verificare tutte le impostazioni, quindi selezionare Install.

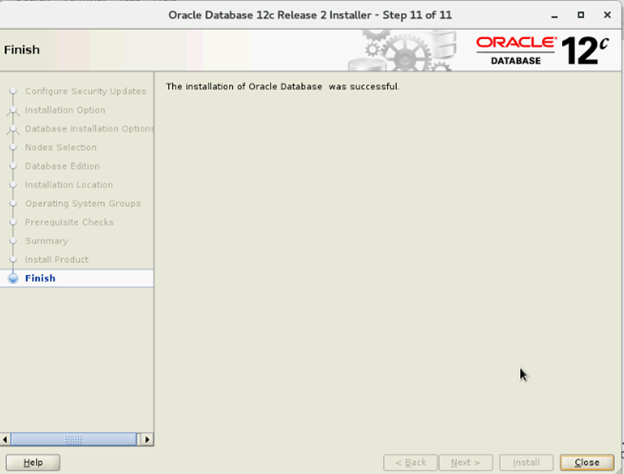

- Al termine del processo di installazione, viene visualizzata la procedura guidata Execute Configuration scripts. Seguire le istruzioni riportate nella procedura guidata, quindi cliccare su OK.

- Nella finestra Finish, cliccare su Close.

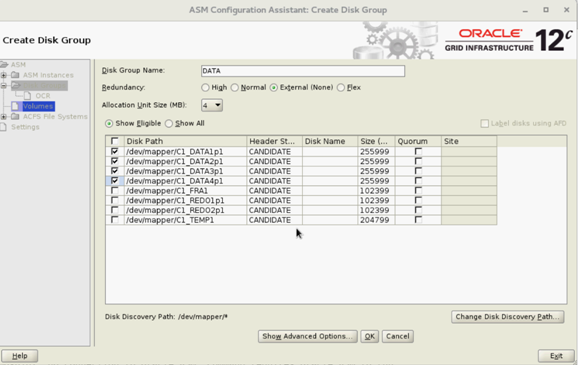

6. Creazione di un gruppo di dischi utilizzando ASM Configuration Assistant (ASMCA)

Questa sezione illustra la procedura per la creazione di un gruppo di dischi ASM per i file di database e la Flashback Recovery Area (FRA).

- Accedere come utente grid e avviare asmca da /u01/app/12.2.0/Grid/bin/asmca.

- Creare un gruppo di dischi "DATA" con External Redundancy mediante la selezione dei dischi appropriati.

- Creare due gruppi di dischi "REDO" (REDO1 e REDO2) con External Redundancy selezionando almeno un disco per gruppo di dischi REDO.

- Creare un gruppo di dischi "FRA" con External Redundancy mediante la selezione dei dischi appropriati.

- Creare un gruppo di dischi "TEMP" con External Redundancy mediante la selezione dei dischi appropriati.

- Verificare tutti i gruppi di dischi richiesti e cliccare su Exit per chiudere l'utilità ASMCA.

- Modificare lo striping ASM per la granularità fine per i gruppi di dischi REDO, TEMP e FRA come utente grid utilizzando i comandi seguenti:

SQL> ALTER DISKGROUP REDO ALTER TEMPLATE onlinelog ATTRIBUTES (fine)

SQL> ALTER DISKGROUP TEMP ALTER TEMPLATE tempfile ATTRIBUTES (fine)

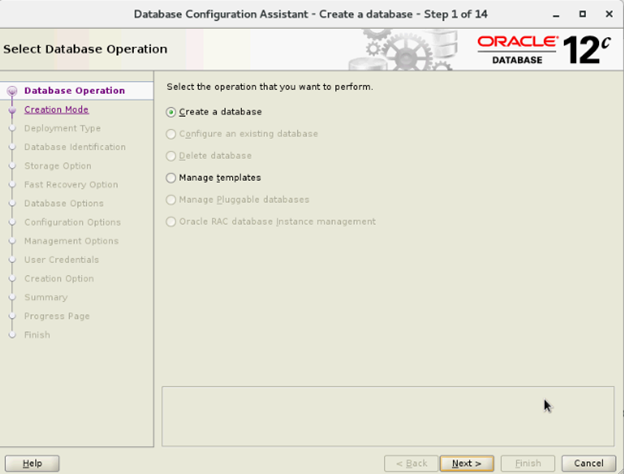

7. Creazione di un database utilizzando DBCA

I seguenti passaggi si riferiscono al nodo 1 dell'ambiente cluster, se non diversamente specificato:

- Accedere come utente Oracle.

- Da $, eseguire l'utilità DBCA digitando $/bin/dbca.

- Nella finestra Select Database Operation, selezionare Create Database, quindi cliccare su Next.

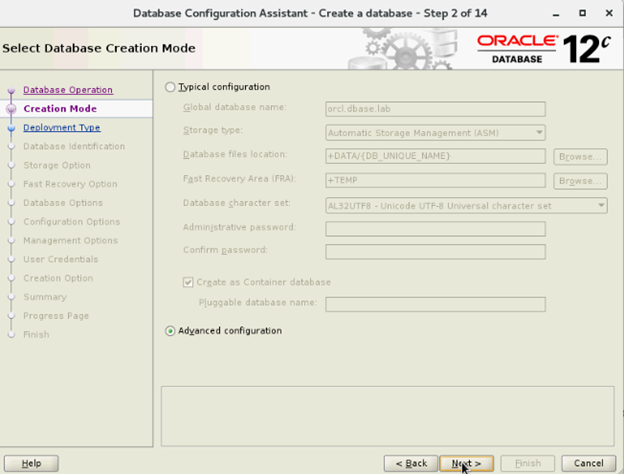

- Nella finestra Select Database Creation Mode, selezionare Advanced configuration, quindi cliccare su Next.

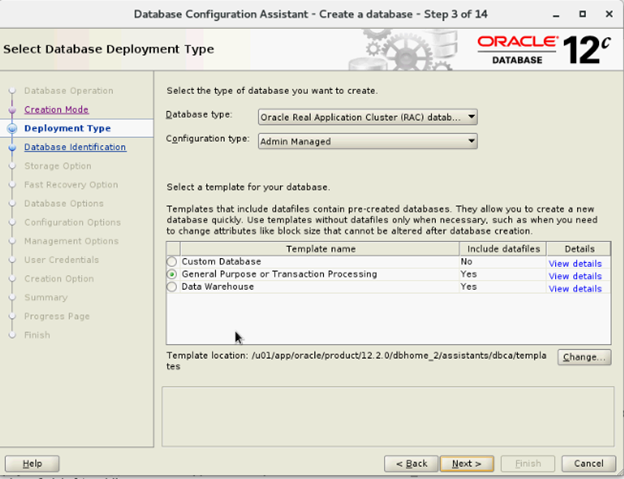

- Nella finestra Select Database Deployment , selezionare Oracle Real Application Cluster (RAC) database per Database type e Admin-Managed per Configuration Type. Selezionare un modello, quindi cliccare su Next.

- Nella finestra Select List of nodes, selezionare i nodi, quindi cliccare su Next.

- Nella finestra Specify Database Identification Details:

- Nella finestra Storage Options, selezionare la posizione di storage dei file di dati e deselezionare l'opzione Use Oracle-Managed Files (OMF), quindi cliccare su Next.

- Nella finestra Select Fast Recovery Option, selezionare Specify Fast Recovery Area, quindi cliccare su Next.

- Nella finestra Select Oracle Data Vault Config Option, selezionare i valori predefiniti e cliccare su Next.

- Nella finestra Specify Configuration Options, inserire i valori SGA e PGA richiesti, quindi cliccare su Next.

- Nella finestra Specify Management Options, selezionare l'impostazione predefinita, quindi cliccare su Next.

- Nella finestra Specify Database User Credentials, inserire la password, quindi cliccare su Next.

- Nella finestra Select Database Creation Options, cliccare su Customize Storage Locations.

- Creare/modificare i gruppi log Redo in base alla seguente raccomandazione di progettazione:

| Numero del gruppo log Redo | Numero thread | Posizione del gruppo di dischi | Dimensione log Redo |

| 1 | 1 | +REDO1 | 5 GB |

| 2 | 1 | +REDO2 | 5 GB5 GB |

| 3 | 1 | +REDO1 | 5 GB |

| 4 | 1 | +REDO2 | 5 GB |

| 5 | 2 | +REDO1 | 5 GB |

| 6 | 2 | +REDO2 | 5 GB |

| 7 | 2 | +REDO1 | 5 GB |

| 8 | 2 | +REDO2 | 5 GB |

- Nella finestra Summary, cliccare su Finish per creare il database.

- Cliccare su Close nella finestra Finish al termine della creazione del database.