Как развернуть Grid-инфраструктуру и базу данных RAC Oracle 12c (версии 2) в RHEL 7.x

요약: Инструкции и изображения для развертывания Grid-инфраструктуры и RAC-базы данных Oracle 12c (версии 2) в RHEL 7.x

지침

1, Требования к программному обеспечению и оборудованию

1.1. Требования к оборудованию

- Для Oracle требуется не менее 8 Гбайт физической памяти.

- Область подкачки пропорциональна объему ОЗУ, выделенному системе.

| ОЗУ | Область подкачки |

| От 1,5 до 16 Гбайт | Равна объему ОЗУ |

| Более 16 Гбайт | 16GB |

Если включен HugePages, перед расчетом области подкачки следует вычесть память, выделенную для HugePages, из доступной оперативной памяти.

Если включен HugePages, перед расчетом области подкачки следует вычесть память, выделенную для HugePages, из доступной оперативной памяти.

- В следующей таблице указано дисковое пространство, необходимое для установки Oracle:

| Место установки программного обеспечения | Минимальные требования к дисковому пространству |

| Grid Infrastructure home | Не менее 8 Гбайт дискового пространства |

| Oracle Database home | Не менее 6,4 Гбайт дискового пространства |

| Дисковое пространство для хранилища общего доступа | Размеры базы данных и области восстановления Flashback Recovery Area |

- Размер пространства для временных файлов Oracle (/tmp) должен быть не менее 1 Гбайт.

- Для правильного отображения Oracle Universal Installer (OUI) требуется монитор с поддержкой разрешения 1024 x 768.

1.2 Требования к сети

- Рекомендуется проверить, что в каждом узле имеется как минимум три сетевых платы. Одна сетевая плата для общедоступной сети и две сетевые платы для частной сети обеспечивают высокую доступность кластера Oracle RAC. Если вы собираетесь использовать в кластере Automatic Storage Management (ASM), вам потребуется как минимум одна сеть Oracle ASM. Сеть ASM может совместно использовать сетевой интерфейс с частной сетью.

- Имена интерфейсов общедоступной и частной сетей, а также сети ASM должны быть одинаковыми на всех узлах. Например, если в качестве интерфейса общедоступной сети на узле 1 используется «em1», то «em1» должен выступать в качестве интерфейса общедоступной сети на всех остальных узлах.

- Все интерфейсы общедоступной сети для каждого узла должны поддерживать связь со всеми узлами в кластере.

- Все интерфейсы частной сети и сети ASM для каждого узла должны поддерживать связь со всеми узлами в кластере.

- Имя каждого узла должно соответствовать стандарту RFC 952 (www.ietf.org/rfc/rfc952.txt). Имена хостов с символом подчеркивания («_») не допускается.

1,3. Требования к операционной системе

- Red Hat Enterprise Linux (RHEL) 7.x (ядро версии 3.10.0-693.el7.x86_64 или выше).

1.3.1. Разбиение диска операционной системы

Ниже приведены рекомендуемые схемы разбиения дисков при установке RHEL 7 с помощью файла kickstart на локальных жестких дисках со свободным пространством не менее 1,2 Тбайт:

part /boot --asprimary --fstype="xfs" --ondisk=sda --size=1024

part pv.1 --size=1 --grow --ondisk=sda --asprimary

volgroup rhel7 pv.1

logvol / --name=root --fstype=xfs --vgname=rhel7 --size=51200

logvol swap --fstype swap --name=swap --vgname=rhel7 --size=17408

logvol /home --name=home --fstype=xfs --vgname=rhel7 --size=51200

logvol /var --name=var --fstype=xfs --vgname=rhel7 --size=20480

logvol /opt --name=opt --fstype=xfs --vgname=rhel7 --size=20480

logvol /tmp --name=tmp --fstype=xfs --vgname=rhel7 --size=5120

logvol /u01 --name=u01 --fstype=xfs --vgname=rhel7 --size=1 --grow

2. Подготовка серверов к установке Oracle

Перед установкой сети Grid и базы данных необходимо установить перечисленные ниже сценарии развертывания от Dell EMC, которые подготавливают среду для

установки базы данных Oracle.

2,1. Подключение систем к репозиторию RHN или ULN

Перед установкой Grid-инфраструктуры или базы данных должны быть установлены все необходимые RPM-пакеты.

Шаг 1.

- rhel-7-server-optional-rpms

- rhel-7.x

Настройте локальный репозиторий yum, чтобы автоматически установить остальные зависимые RPM-пакеты для выполнения установки Grid-инфраструктуры или базы данных.

- В качестве конфигурации рекомендуется обработка файлов по протоколу HTTP с помощью сервера Apache (имя пакета: httpd). В этом разделе описывается размещение файлов репозитория из хранилища локальной файловой системы. Хотя существуют и другие параметры размещения файлов репозитория, они выходят за рамки данного документа. Настоятельно рекомендуется использовать локальное хранилище файловой системы для ускорения и упрощения обслуживания.

mkdir /media/myISO

mount -o loop myISO.iso /media/myISO

- Чтобы установить и настроить демон HTTP, настройте локальное использование образа DVD на компьютере, на котором будет размещен репозиторий для всех других компьютеров. Создайте файл «/etc/yum.repos.d/local.repo» и введите следующее:

[local]

name=Local Repository

baseurl=file:///media/myISO

gpgcheck=0

enabled=0

- Теперь установите демон службы Apache с помощью следующей команды, которая также временно включит локальный репозиторий для разрешения зависимостей:

yum -y install httpd --enablerepo=local

- Чтобы использовать Apache для обслуживания репозитория, скопируйте содержимое DVD в опубликованный веб-каталог. Выполните следующие команды от имени администратора (обязательно вставьте имя вашего ISO вместо «myISO»):

cp -R /media/myISO/* /var/www/html/myISO

- Этот шаг необходим только в том случае, если на сервере, на котором размещен репозиторий, запущен SELinux. Следующая команда должна быть выполнена от имени администратора. Она восстановит соответствующий контекст SELinux в скопированных файлах:

- Последний шаг — получение DNS-имени или IP-адреса сервера, на котором размещен репозиторий. DNS-имя или IP-адрес хост-сервера будет использоваться для настройки вашего файла repo репозитория yum на клиентском сервере. Ниже приведен пример конфигурации с использованием носителя RHEL 7.x Server из файла конфигурации:/etc/yum.repos.d/myRepo.repo.

[myRepo]

name=RHEL 7.x Base ISO DVD

baseurl= http://reposerver.mydomain.com/myISO

enabled=1

gpgcheck=0

- Вручную установите RPM-пакет «compat-libstdc++» с помощью команды «rpm» или «yum» в каталог, в который скопированы RPM-пакеты.

Пример: rpm -ivh

yum localinstall -y

Шаг 3.

- Установите RPM-пакеты «compat-libstdcc++», выполнив следующую команду:

yum install –y compat-libstdc++.i686

yum install –y compat-libstdc++.x86_64

- Перейдите в раздел Dell Oracle Deployment RPMs for Oracle 12cR2 on RHEL7.x для RH и скачайте или скопируйте предоставленные Dell файлы RPM на серверы, на которых будет выполняться установка Grid-инфраструктуры или базы данных. Ниже приведен список файлов RPM. Загрузите только необходимые.

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm предназначен для выполнения следующих действий:

- Отключить transparent_hugepages в grub2.cfg.

- Отключить numa в grub2.cfg.

- Создать пользователей и группы Oracle oinstall и dba.

- Задать параметры ядра sysctl.

- Установить пользовательские ограничения (nobile, nproc, stack) для пользователя Oracle.

- Задать NOZEROCONF=yes в файле /etc/sysconfig/network.

- Создать пользователя grid и группы «asmadmin», «asmdba», «asmoper», «backupdba», «dgdba», «kmdba».

- Установить пользовательские ограничения (nobile, nproc, stack) для пользователя grid.

- Задать параметры ядра sysctl.

- Задать RemoveIPC=no, чтобы гарантировать, что семафоры, заданные для пользователей, не будут потеряны после выхода пользователя из системы.

- Установить эти два rpm:

yum localinstall –y dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

2,2. Настройка сети

2.2.1,. Общедоступная сеть

Чтобы настроить общедоступную сеть на каждом узле:

- Войдите в систему как пользователь root.

- Перейдите в каталог «/etc/sysconfig/network-scripts» и отредактируйте файл ifcfg-em#, где «#» — номер сетевого устройства.

NAME="Oracle Public"

DEVICE= "em1"

ONBOOT=yes

TYPE= Ethernet

BOOTPROTO=static

IPADDR=<routable IP address>

NETMASK=<netmask>

GATEWAY=<gateway_IP_address>

- Задайте имя хоста с помощью следующей команды:

hostnamectl set-hostname <host-name>

, где <host-name> — это имя хоста, который используется для установки.

- Введите «service network restart», чтобы перезапустить сетевую службу.

- Введите «ifconfig», чтобы убедиться, что IP-адреса заданы правильно.

- Чтобы проверить конфигурацию сети, отправьте ping-запрос на каждый общедоступный IP-адрес от какого-либо клиента в локальной сети, которая не входит в кластер.

- Подключитесь к каждому узлу, чтобы убедиться, что общедоступная сеть работает. Введите команду ssh, чтобы проверить работу команды secure shell (ssh).

2.2.2,. Частная сеть

В примере ниже приведены пошаговые инструкции по включению резервного соединения с помощью HAIP во время новой установки Grid-инфраструктуры Oracle 12c.

- Отредактируйте файл «/etc/sysconfig/network-scripts/ifcfg-emX», где «X» — номер устройства em, а «ifcfg-emX» — файлы конфигурации сетевых адаптеров, которые будут использоваться для частного соединения.

DEVICE=em2

BOOTPROTO=static

HWADDR=

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.140

NETMASK=255.255.255.0

DEVICE=em3

HWADDR=

BOOTPROTO=static

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.141

NETMASK=255.255.255.0

- Сохранив оба файла конфигурации, перезапустите сетевую службу с помощью команд ниже:

nmcli connection reload

nmcli device disconnect em2

nmcli connection up em2

- Повторите эти действия для каждого измененного интерфейса.

- После выполнения указанных выше действий система будет готова к включению HAIP с помощью установщика Oracle Grid Infrastructure. Когда будут выполнены все необходимые условия для установки Oracle, необходимо выбрать интерфейсы em2 и em3 в качестве «частных» на экране Network Interface Usage.

- Этот шаг обеспечивает резервируемую взаимосвязь после успешного завершения и запуска Grid-инфраструктуры Oracle.

3.2.2,. Сеть Oracle Flex ASM

Oracle Flex ASM может использовать либо те же частные сети, что и Oracle Clusterware, либо собственные выделенные частные сети. Каждую сеть можно классифицировать как «PUBLIC», «PRIVATE+ASM», «PRIVATE» или «ASM».

4.2.2,. Требования к разрешению IP-адресов и имен

Можно настроить IP-адрес узлов кластера, выбрав один из следующих вариантов:

- Сервер доменных имен (DNS).

2.2.4.1. Сервер доменных имен (DNS).

Чтобы настроить Oracle 12c RAC с помощью Oracle (без GNS):

В таблице ниже описаны различные интерфейсы, настройки IP-адресов и разрешения в кластере:

|

Интерфейс

|

Тип

|

Способ устранения

|

|

Общедоступная

|

Статическая

|

DNS

|

|

Частный доступ

|

Статическая

|

Не требуется

|

|

ASM

|

Статическая

|

Не требуется

|

|

Виртуальный IP-адрес узла

|

Статическая

|

Не требуется

|

|

Виртуальный IP-адрес SCAN

|

Статическая

|

Не требуется

|

Настройка DNS-сервера

Чтобы настроить изменения на DNS-сервере для кластера Oracle 12c с помощью DNS (без GNS), выполните следующие действия:

Настройте разрешение имени SCAN на DNS-сервере. Имя SCAN, настроенное на DNS-сервере с помощью политики циклического перебора, должно сопоставляться с тремя общедоступными IP-адресами (рекомендуется), хотя для соответствия минимальным требованиям достаточно одного общедоступного IP-адреса.

Например:

scancluster IN A 192.0.2.1

В 192.0.2.2

В 192.0.2.3

где «scancluster» — это имя SCAN, предоставленное во время установки Oracle Grid.

Настройка DNS-клиента

Чтобы настроить необходимые изменения на узлах кластера для разрешения имен:

- Настройте файл resolv.conf на узлах кластера, чтобы он содержал записи сервера имен, разрешаемых DNS-сервером.

nmcli connection modify ipv4.dns ipv4.dns-search

- Убедитесь, что конфигурация порядка /etc/nsswitch.conf управляет порядком службы имен. В некоторых конфигурациях NIS может вызывать проблемы с разрешением адресов Oracle SCAN. Рекомендуется поместить запись NIS в конец списка поиска.

Например, hosts: dns files nis.

3. Подготовка хранилища общего доступа для установки Oracle RAC

Для установки Oracle RAC требуются LUN общего доступа для хранения Oracle Cluster Registry (OCR), голосующие диски (voting disk), файлы Oracle Database и области FRA. В следующей таблице показано типичное рекомендуемое распределение томов для Oracle Database 12c:

| Тип/назначение тома базы данных | Количество томов | Размер тома |

| OCR/VOTE | 3 | 50 Гбайт каждый |

| DATA | 4 | 250 Гбайт1 каждый |

| REDO2 | 2 | Не менее 50 Гбайт каждый |

| FRA | 1 | 100GB3 |

| TEMP | 1 | 100GB |

1 Подберите размер каждого тома в зависимости от базы данных. 2 Рекомендуется по крайней мере две группы дисков REDO ASM, каждая из которых содержит хотя бы один том хранения. 3 В идеале размер должен быть в 1,5 раза больше размера базы данных, если позволяет полезная емкость системы хранения.

постоянную привязку имен на узлах в кластере.

3,1. Настройка Device Mapper Multipath для системы хранения XtremIO

Инструмент Device Mapper Multipath предназначен для того, чтобы включить несколько маршрутов ввода-вывода для повышения производительности и обеспечения согласованного именования. Управление несколькими путями позволяет достичь этого за счет объединения маршрутов ввода-вывода в один канал привязки устройств и правильного распределения нагрузки ввода-вывода. В этом разделе представлены передовые практики по настройке многопутевой привязки устройств на сервере Dell PowerEdge. Убедитесь, что версии device-mapper и многопутевого драйвера не ниже следующих:

- rpm -qa | grep device-mapper-multipath

device-mapper-multipath

- Включите многопутевой режим с помощью mpathconf -enable.

- Настройте многопутевой режим XtremIO, изменив /etc/multipath.conf следующим образом:

device {

vendor XtremIO

product XtremApp

path_grouping_policy multibus

path_checker tur

path_selector "queue-length 0"

rr_min_io_rq 1

user_friendly_names yes

fast_io_fail_tmo 15

failback immediate

}

- Добавьте к каждому тому соответствующие удобные имена с соответствующим идентификатором «scsi_id». «scsi_id» можно получить с помощью следующей команды:

/usr/lib/udev/scsi_id -g -u -d /dev/sdX

- Найдите раздел «multipath» в файле «/etc/multipath.conf». В этом разделе укажите идентификатор «scsi_id» каждого тома и псевдоним, чтобы обеспечить согласованный принцип обозначения для всех узлов. Пример показан ниже:

multipaths {

multipath {

wwid <out put of step4 for volume1>

alias alias_of_volume1

}

multipath {

wwid <out put of step4 for volume2>

alias alias_of_volume2

}

}

- Перезапустите службу демона multipath с помощью следующей команды:

Service multipathd restart

- Убедитесь, что псевдоним томов с несколькими путями отображается правильно:

multipath -ll

- Повторите все шаги для всех узлов.

3,2. Разбиение диска общего доступа

В этом разделе описано, как с помощью утилиты parted создать один раздел на томе или виртуальном диске, который охватывает весь диск.

Разбейте каждый том базы данных, который был настроен с помощью device-mapper, выполнив следующую команду:

$> parted -s /dev/mapper/<volume1> mklabel msdos

$> parted -s /dev/mapper/<volume1> primary 2048s 100%

Повторите эти действия для всех требуемых томов.

-

Повторите описанные выше действия для всех томов и перезапустите multipathd на всех остальных узлах:

systemctl restart multipathd.service

-

Перезагрузите систему, если созданный раздел отображается неправильно.

3.3 Использование правил udev для разрешений и поддержки хранения данных на диске

В Red Hat Enterprise Linux 7.x имеется возможность использовать правила udev, чтобы система правильно управляла разрешениями узлов устройств. В этом случае имеется в виду правильная настройка разрешений для наших LUN/томов, обнаруженных операционной системой. Важно отметить, что правила udev выполняются в порядке перечисления. При создании правил udev для настройки разрешений включите префикс «60-» и добавьте «.rules» в конец имени файла.

- Создайте файл «60-oracle-asmdevices.rules» в «/etc/udev/rules.d».

- Убедитесь, что для каждого блочного устройства имеется запись в файле, как показано ниже.

#---------------------start udev rule contents ------------------------#

KERNEL=="dm-*", ENV =="C1_OCR1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA4p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_FRA?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_TEMP?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

- Выполните команду «udevadm trigger», чтобы применить правило.

- Скопируйте правила udev на все узлы и запустите триггер udevadm, чтобы применить правила.

4. Установка Grid-инфраструктуры Oracle 12c для кластера

4.1 Настройка системных часов для всех узлов

Чтобы предотвратить сбои во время установки, настройте системные часы на всех узлах одинаковым образом. Синхронизируйте системные часы узла со службой синхронизации времени кластера (CTSS), встроенной в Oracle 12c. Чтобы включить CTSS, отключите службу Network Time Protocol Daemon (NTPD) операционной системы, используя команды ниже в следующем порядке:

-

systemctl stop chronyd.service

-

systemctl disable chronyd.service

-

mv /etc/chrony.conf /etc/ntp.chrony.orig

Если не указано иное, следующие действия предназначены для узла 1 в вашей кластерной среде.

- Войдите в систему как пользователь root.

- Если вы находитесь не в графической среде, запустите X Window System, введя с клавиатуры «starttx».

- Откройте окно терминала и введите «xhost +».

- Смонтируйте носитель Grid-инфраструктуры Oracle.

- Войдите в систему как пользователь grid, например «su - grid».

- Введите следующую команду для запуска универсального установщика Oracle: /runInstaller

- В окне «Select Configuration Option» выберите «Configure Grid Infrastructure for a Cluster» и нажмите «Next».

- В окне «Cluster Configuration» выберите «Configure an Oracle Standalone Cluster» и нажмите «Next».

- В окне «Grid Plug and Play Information» введите следующую информацию:

-

Cluster Name — введите имя кластера;

-

SCAN Name — введите имя, зарегистрированное на DNS-сервере и уникальное для всего кластера. Подробнее о настройке имени SCAN см. в разделе «Требования к разрешению IP-адресов и имен»;

-

SCAN Port — оставьте порт по умолчанию (1521).

-

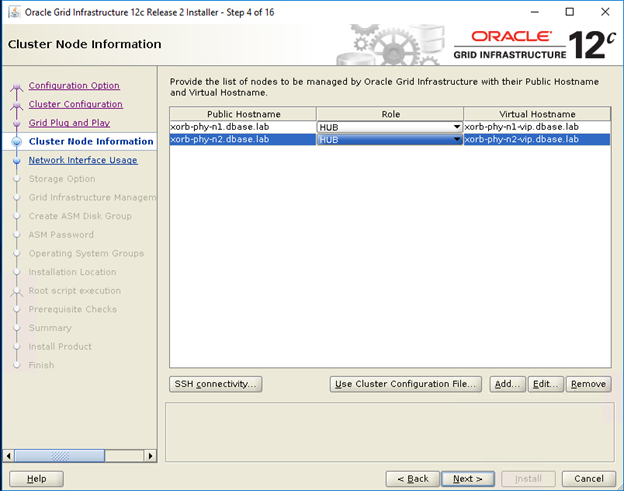

- В окне «Cluster Node Information» нажмите «Add», чтобы добавить дополнительные узлы, которыми необходимо управлять с помощью Grid-инфраструктуры Oracle.

- Введите информацию об общедоступном имени хоста для узлов-концентраторов (hub) и конечных (leaf) узлов кластера.

- Введите роль узла кластера.

- Повторите 3 описанных выше шага для каждого узла в кластере.

- Выберите «SSH connectivity» и настройте подключение SSH без пароля. Для этого введите пароль ОС для пользователя grid и нажмите «Setup».

- Нажмите «OK» и «Next», чтобы перейти к следующему окну.

- В окне «Specify Network Interface Usage» убедитесь, что для имен интерфейсов выбраны правильные типы интерфейсов. В раскрывающемся списке «Use for» выберите требуемый тип интерфейса. Доступные варианты: «Public», «Private», «ASM», «ASM & Private». Нажмите «Далее»

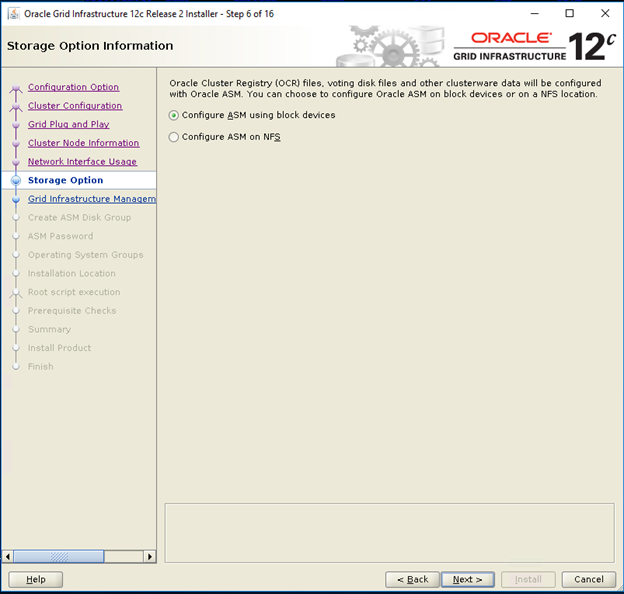

- В окне «Storage option information» выберите «Configure ASM using block devices» и нажмите «Next».

- В окне «Grid Infrastructure Management Repository Option» выберите «No for Configure Grid Infrastructure Management» и нажмите «Next».

- В окне «Create ASM Disk Group» введите следующую информацию:

-

Disk Group Name — введите имя, например «OCR».

-

Redundancy — для OCR и голосующих дисков выберите «High», если доступно пять дисков ASM, выберите «Normal», если доступно три диска ASM, или выберите «External», если доступен один диск ASM (не рекомендуется).

-

- В окне «ASM Password» выберите соответствующий параметр в «Specify the passwords for these accounts» и введите пароли. Нажмите кнопку «Далее».

- В окне «Failure Isolation Support» выберите «Do Not use Intelligent Platform Management Interface (IPMI)».

- В окне «Management options» оставьте значения по умолчанию и нажмите «Next».

- В окне «Privileged Operating Systems Groups» выберите:

-

«asmdba» для Oracle ASM DBA (OSASM) Group;

-

«asmoder» для Oracle ASM Operator (OSOPER) Group;

-

«asmdba» для Oracle ASM Administrator (OSDBA) Group.

-

- В окне «Specify Installation Location» укажите значения Oracle Base и Software Location, настроенные в Dell Oracle Utilities RPM.

- Oracle Base — /u01/app/grid;

- Software Location — /u01/app/12.1.0/grid_1.

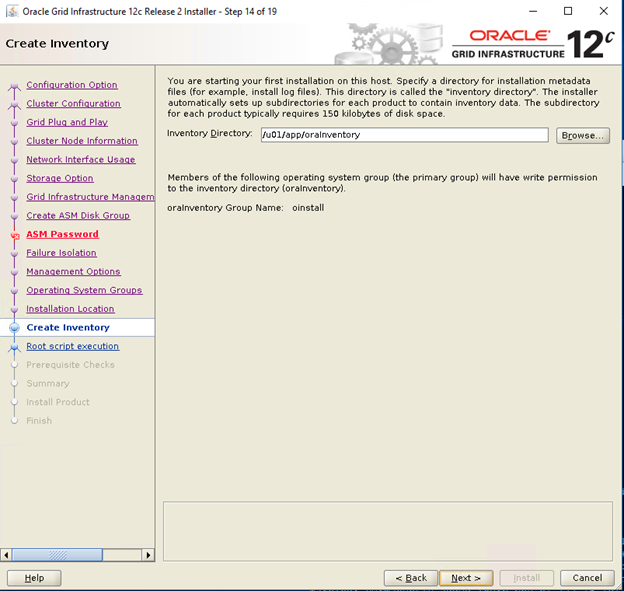

- В окне «Create Inventory» укажите местонахождение Inventory Directory. Нажмите «Далее»

Местонахождение Inventory Directory по умолчанию на основе Dell Oracle Utilities RPM — /u01/app/oraInventory.

Местонахождение Inventory Directory по умолчанию на основе Dell Oracle Utilities RPM — /u01/app/oraInventory.

- В окне «Root script execution configuration» снимите флажок «Automatically run configuration scripts» и нажмите «Next».

- В окне «Summary» проверьте все настройки и выберите «Install».

- В окне «Install Product» проверьте состояние установки Grid-инфраструктуры.

- В окне «Execute Configuration Scripts» выполните сценарии root.sh на обоих узлах и нажмите «OK».

- В окне «Finish» нажмите «Close».

5. Установка Oracle 12c Database

5,1. Установка ПО Oracle 12c Database (RDBMS)

Если не указано иное, следующие действия предназначены для узла 1 в вашей кластерной среде.

- Войдите в систему как пользователь root и введите «xhost+».

- Смонтируйте носитель Oracle Database 12c.

- Войдите в систему как пользователь Oracle. Для этого введите «su - oracle».

- Запустите сценарий установщика с носителя Oracle Database:

<CD_mount>/runInstaller

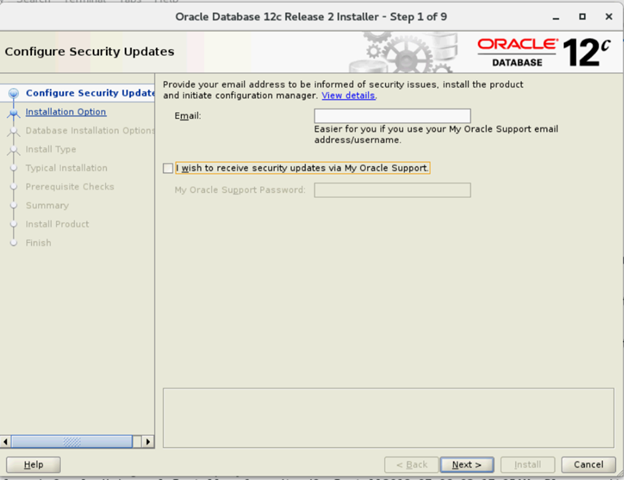

- В окне «Configure Security Updates» введите учетные данные My Oracle Support, чтобы получать обновления для системы безопасности, или нажмите «Next».

- В окне «Select Installation Option» выберите «Install database software only».

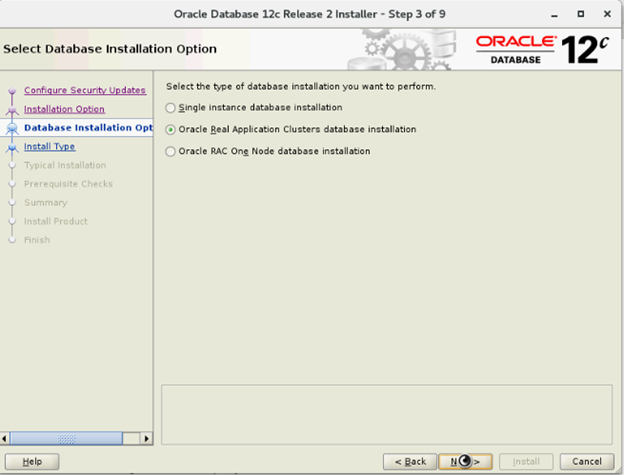

- В окне «Select Database Installation Option» выберите «Oracle Real Application Clusters database installation» и нажмите «Next».

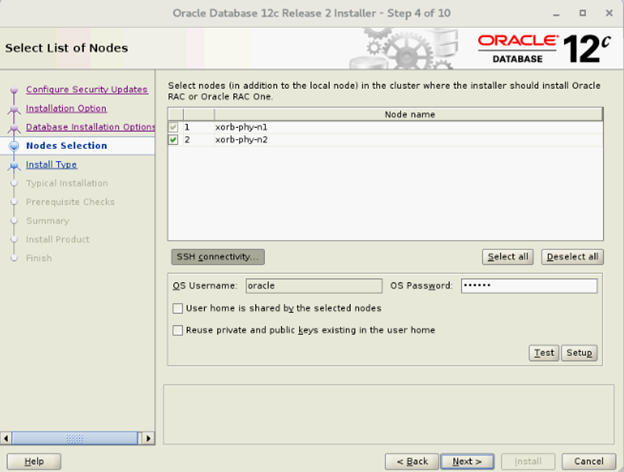

- В окне «Select List of Nodes» выберите все узлы-концентраторы, пропустите конечные узлы, нажмите «SSH Connectivity» и настройте подключение SSH без пароля, введя пароль ОС для пользователя Oracle и выбрав «Setup». Нажмите «OK» и «Next», чтобы перейти к следующему окну.

- В окне «Select Database Installation Option» выберите «Oracle Real Application Clusters database installation» и нажмите «Next».

- В окне «Select List of Nodes» выберите все узлы-концентраторы, пропустите конечные узлы, нажмите «SSH Connectivity» и настройте подключение SSH без пароля, введя пароль ОС для пользователя Oracle и выбрав «Setup». Нажмите «OK» и «Next», чтобы перейти к следующему окну.

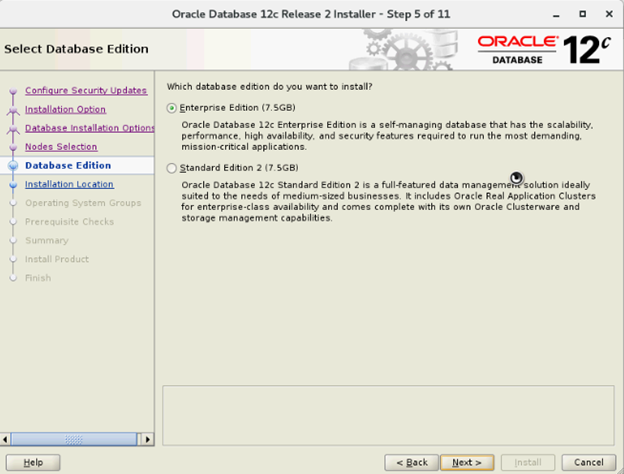

- В окне «Select Database Edition» выберите «Enterprise Edition» и нажмите «Next».

- В окне «Specify Installation Location» укажите местонахождения Oracle Base и Software Location, настроенные в Dell Oracle Utilities RPM.

- Oracle Base — /u01/app/oracle;

- Software Location — /u01/app/oracle/product/12.1.0/dbhome_2.

- В окне «Privileged Operating System Groups» выберите «dba» для «Database Administrator (OSDBA) group», «dba» для «Database Operator (OSOPER) group», «backupdba» для «Database Backup and Recovery (OSBACKUPDBA) group», «dgdba» для «Data Guard administrative (OSDGDBA) group», «kmdba» для «Encryption Key Management administrative (OSKMDBA) group» и нажмите «Next».

- В окне «Summary» проверьте все настройки и выберите «Install».

- После завершения процесса установки появится окно «Execute Configuration scripts». Следуйте инструкциям в мастере и нажмите «OK».

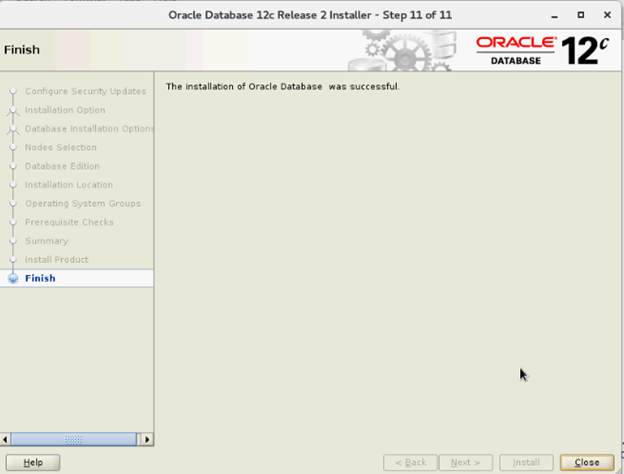

- В окне «Finish» нажмите «Close».

6. Создание группы дисков с помощью ASM Configuration Assistant (ASMCA)

В этом разделе описаны процедуры создания группы дисков ASM для файлов базы данных и области восстановления Flashback Recovery Area (FRA).

- Войдите в систему как пользователь grid и запустите asmca из /u01/app/12.2.0/grid/bin/asmca.

- Создайте группу дисков «DATA» с внешним резервированием, выбрав соответствующие подходящие диски.

- Создайте две группы дисков «REDO» (REDO1 и REDO2) с внешним резервированием, выбрав по крайней мере один подходящий диск для каждой группы дисков REDO.

- Создайте группу дисков «FRA» с внешним резервированием, выбрав соответствующие подходящие диски.

- Создайте группу дисков «TEMP» с внешним резервированием, выбрав соответствующие подходящие диски.

- Проверьте все необходимые группы дисков и нажмите «Exit», чтобы закрыть утилиту ASMCA.

- Измените распределение данных с ASM на детализированное для групп дисков REDO, TEMP и FRA (как пользователь grid) с помощью указанных ниже команд.

SQL> ALTER DISKGROUP REDO ALTER TEMPLATE onlinelog ATTRIBUTES (fine)

SQL> ALTER DISKGROUP TEMP ALTER TEMPLATE tempfile ATTRIBUTES (fine)

7. Создание базы данных с помощью DBCA

Следующие действия применимы к узлу 1 кластерной среды, если не указано иное:

- Войдите в систему как пользователь oracle.

- Из $ запустите утилиту DBCA. Для этого введите «$/bin/dbca».

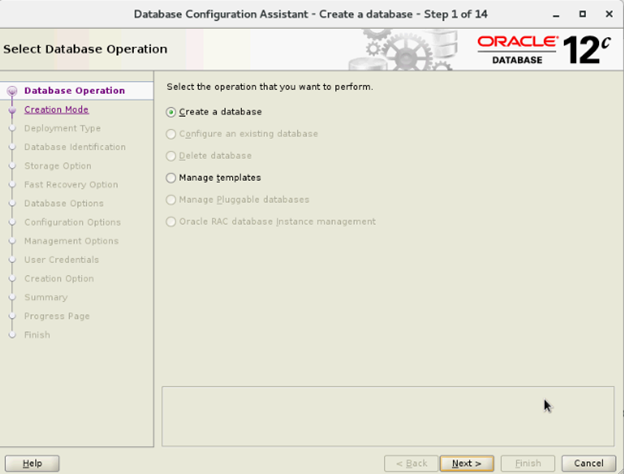

- В окне «Select Database Operation» выберите «Create database» и нажмите «Next».

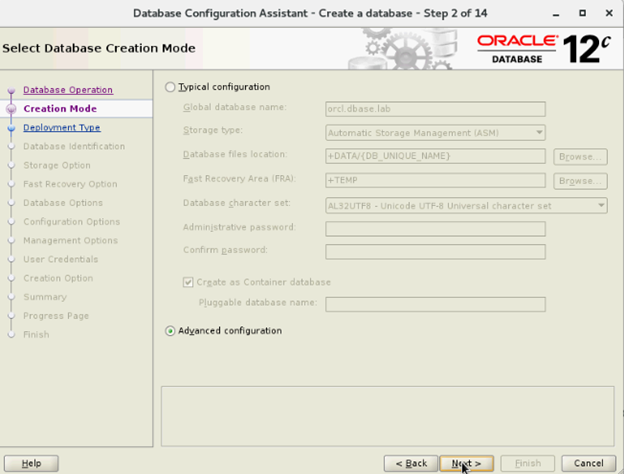

- В окне «Select Creation Mode» выберите «Advanced Mode» и нажмите «Next».

- В окне «Select Database Deployment» выберите «Oracle Real Application Cluster (RAC) database» в поле «Database type», выберите «Admin-Managed» в «Configuration Type», выберите «Template» и нажмите «Next».

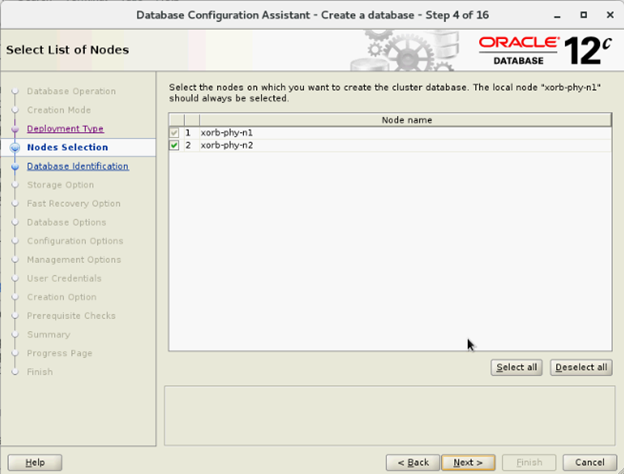

- В окне «Select List of nodes» выберите узлы и нажмите «Next».

- В окне «Specify Database Identification Details»:

- В окне «Storage Options» выберите расположение хранилища файлов данных, снимите флажок «Use Oracle-Managed Files (OMF)» и нажмите «Next».

- В окне «Select Fast Recovery Option» выберите расположение «Specify Fast Recovery Area» и нажмите «Next».

- В окне «Select Oracle Data Vault Config Option» оставьте параметры по умолчанию и нажмите «Next».

- В окне «Specify Configuration Options» укажите соответствующие значения SGA и PGA и нажмите «Next».

- В окне «Management options» оставьте значения по умолчанию и нажмите «Next».

- В окне «Specify Database User Credentials» введите пароль и нажмите «Next»

- В окне «Select Database Creation Option» нажмите «Customize Storage Locations».

- Создайте или измените группы журналов повторного выполнения (Redo Log Group) на основе следующей рекомендации:

| Номер группы журналов повторного выполнения | Номер потока | Расположение группы дисков | Размер журнала повторного выполнения |

| 1 | 1 | +REDO1 | 5 GB |

| 2 | 1 | +REDO2 | 5 Гбайт |

| 3 | 1 | +REDO1 | 5 GB |

| 4 | 1 | +REDO2 | 5 GB |

| 5 | 2 | +REDO1 | 5 GB |

| 6 | 2 | +REDO2 | 5 GB |

| 7 | 2 | +REDO1 | 5 GB |

| 8 | 2 | +REDO2 | 5 GB |

- В окне «Summary» нажмите «Finish», чтобы создать базу данных.

- После создания базы данных нажмите «Close» в окне «Finish».