Article Number: 000113009

Sådan konfigureres gæst RDMA på Windows Server

Summary: I denne artikel forklares det, hvordan du konfigurerer Gæste-RDMA på Windows Server.

Article Content

Instructions

Indholdsfortegnelse

-

Introduktion til Remote Direct Memory Access (RDMA)

-

Testmiljø

-

Hardwarekonfiguration

-

Konfiguration af gæste-RDMA

-

Powershell Cmdlets

-

Links til download

1. Introduktion til Remote Direct Memory Access (RDMA)

RDMA (Remote Direct Memory Access) er en fantastisk teknologi, der gør det muligt for computere at overføre data på tværs af netværket uden at involvere CPU- eller OS-ressourcer fra de involverede værter (beregning/lagring), hvilket forbedrer overførselshastighed og ydeevne, reducerer ventetid og CPU-omkostninger.Der er to populære RDMA-implementeringer i dag:

RoCE

- Transport: UDP/IP (RoCE v2)

- Stol på DCB (Data Center Bridging)

iWarp

- Underliggende netværk: TCP/IP

- TCP leverer flowstyring og styring af overbelastning

RoCE er stærkt afhængig af DCB-konfiguration såsom ETS (Enhanced Transmission Service) og PFC (Priority Flow Control), hvilket kan blive et problem, hvis netværksswitche ikke er konfigureret korrekt. iWARP kræver ingen switchkonfiguration.

Microsoft begyndte at understøtte RDMA på Windows Server 2012 og tilføjede nye funktioner i de senere Windows Server OS'er. En funktion, som er tilgængelig på Microsoft nyeste OS, Windows Server 2019, er muligheden for at præsentere RDMA for gæste-OS'en (VM). Dette gør det muligt for gæsten at have samme adgang med kort ventetid til et netværks lager som den indbyggede vært, hvilket reducerer belastningen af CPU'en og forbedrer overførselshastigheden/ydeevnen direkte i VM'en.

Dell EMC tilbyder fremragende muligheder for 25 Gbps RDMA som f.eks. Cavium QLogic FastLinQ 41262 Dual Port 25 GbE SFP28 (IWarp/RoCE) og Mellanox ConnectX-4 Lx 25 Gbps RDMA (RoCE). I dette eksempel bruges Mellanox ConnectX-4 Lx RDMA (RoCEv2-tilstand) til at demonstrere gæste-RDMA-funktionen.

2. Lab-miljø

Servere: 2 x Dell EMC R7425 (AMD EPYC 7551 32-core processor), 256 GB hukommelse, Mellanox ConnectX-4 Lx fuldt opdateret (BIOS, firmware, drivere og operativsystem)Roller/funktioner installeret: Hyper-V, DCB, failover-klyngedannelse, S2D-switch

: Dell EMC S5048F-ON – MGMT VLAN 2, SMB VLAN 15

3. Hardwarekonfiguration

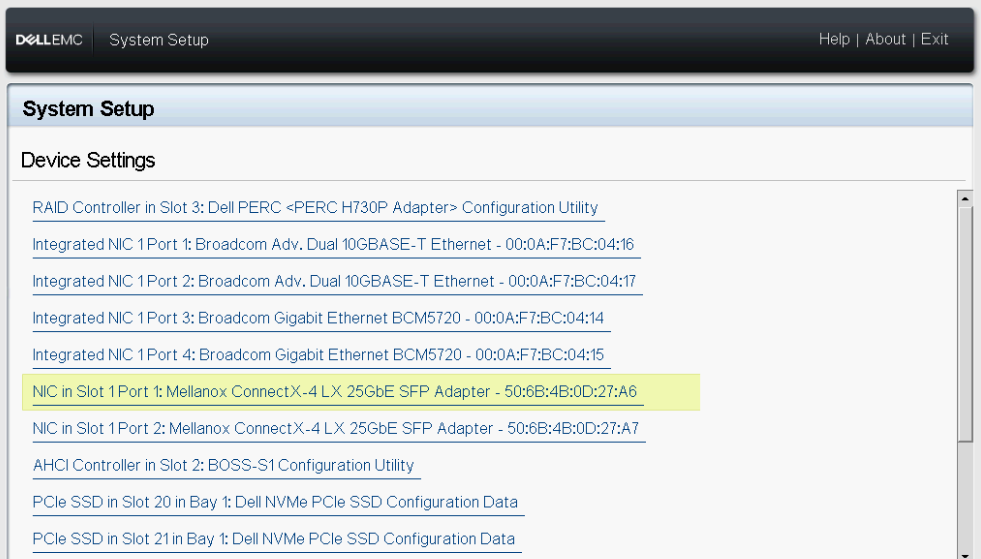

1. Genstart serverne, og gå til systemopsætningen (tryk på F2 under POST).

2. Vælg Enhedsindstillinger.

Figur 1 - BIOS-enhedsindstillinger

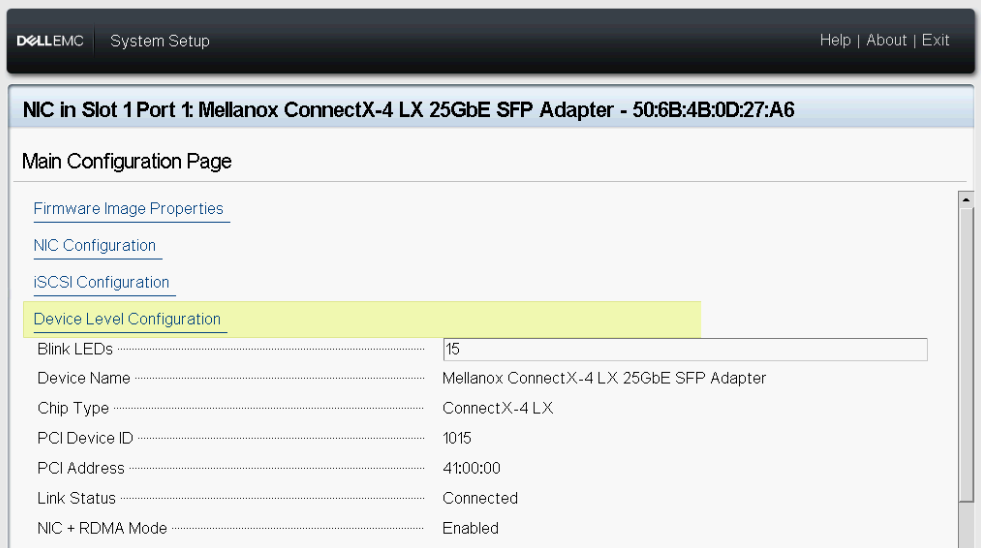

3. Vælg netværkskortet i slot 1 Port 1 – Mellanox

Figur 2 – Mellanox slot 1 port 1 enhedsindstillinger

Figur 2 – Mellanox slot 1 port 1 enhedsindstillinger

4. Gå til Konfiguration

på enhedsniveau Figur 3 - Konfiguration

på enhedsniveau Figur 3 - Konfiguration

på enhedsniveau 5. Vælg SR-IOV i virtualiseringstilstand.

Figur 4 - SR-IOV-indstilling

6. Gentag trinnene ovenfor på NIC i slot 1 Port 2 - Mellanox.

Figur 5 - Mellanox slot 1 port 2 enhedsindstillinger

7. Gå tilbage til Hovedmenuen Systemopsætning, og vælg derefter System BIOS.

Figur 6 - System BIOS

8. Vælg Integrerede enheder.

Figur 7 - BIOS-integrerede enheder

9. Aktivér indstillingen SR-IOV Global Enable.

Figur 8 - SR-IOV Global

10. Gem din konfiguration og genstart serveren.

4. Konfiguration af gæste-RDMA

1. Installer Windows Server 2019+

2. Installer Hyper-V-rollen og DCB-funktionen (Data Center Bridging).

3. Konfigurer QoS (Quality-of-Service), DCB, PFC, ETS. Sørg for, at serverens netværkskort og QoS-konfiguration stemmer overens med switchkonfigurationen.

4. Konfigurer Hyper-V SET (Switch Embedded Team).

Figur 9 - Konfiguration af

vSwitch 5. Test RDMA-kommunikationen mellem de fysiske servere, inden VM'erne konfigureres. Download Microsoft Diskspd og Microsoft test-RDMA PowerShell-scriptet. Fortsæt kun med trinene nedenfor, hvis kommunikationen fungerer korrekt. Ellers skal du kontrollere switchens konfiguration og/eller DCB-indstillinger på værten.

Figur 10 - Test-RDMA fysiske værter

6. Kontroller, om SR-IOV er aktiveret på RDMA-adapterne på begge servere.

Figur 11 - SR-IOV aktiveret

7. Opret to Gen 2 VM'er (gæst OS), en på hver server, og installer derefter Windows Server 2019. I dette scenarie oprettes et gæsteoperativsystem med to vNIC'er, en til MGMT-trafik (VLAN 2) og en til SMB-trafik (VLAN 15).

Figur 12 - Gæst OS Network Configuration Host R7425-01

Figur 13 - Virtual Machine Network Configuration Host R7425-02

8. Luk VM erne.

9. Aktivér SR-IOV og RDMA på gæsteoperativsystemet.

Figur 14 - Aktiver SR-IOV/RDMA på Guest OSes

10. Start VM'erne, og åbn derefter Enhedshåndtering. Mellanox Virtual Function (VF) skal være angivet under Netværksadaptere. VF'en vises ikke som en almindelig netværksadapter i Netværksforbindelser, som vist på Figur 15.

Figur 15 – Gæste-OS Enhedshåndtering og Netværksforbindelser

Figur 16 - Aktivér RDMA på SMB vNIC

12. Test gæste-RDMA.

Bemærk: Det er vigtigt at angive IfIndex (vNIC Interface Index) og VfIndex (Mellanox VF Interface Index).

Bemærk: Det er vigtigt at angive IfIndex (vNIC Interface Index) og VfIndex (Mellanox VF Interface Index).

Figur 17 – Test-RDMA gæste-OS

5. PowerShell-cmdletter

#Create new virtual switch with SRIOV option enabled New-VMSwitch -Name xxxx -NetadapterName xxxx,xxxx -AllowManagementOS $true -EnableEmbeddedTeaming $true -EnableIov $true #Verify if SRIOV is enabled on physical adapter Get-NetAdapterSriov -Name xxxx #Get VM network configuration Get-VM -Name xxxx| Get-VMNetworkAdapter #Get VM network VLAN configuration Get-VM -Name | Get-VMNetworkAdapterVlan #Set VM SRIO and RDMA on Virtual Machine(Guest OS) vNIC Get-VM -Name xxxx | Set-VMNetworkAdapter -Name xxx -IovWeight 100 -IoVQueuePairsRequested 2 Get-VM -Name xxxx | Set-VMNetworkAdapterRdma -Name xxx -RdmaWeight 100 #Enable RDMA on NetAdapter Enable-NetAdapterRdma -Name xxxx #Test-Rdma Physical Host .\Test-Rdma.ps1 -IfIndex xx -IsRoCE $true -RemoteIpAddress xxx.xxx.xxx.xxx -PathToDiskspd xxxxx #Test-Rdma Virtual Machine (Guest OS) .\Test-Rdma.ps1 -IfIndex xx -IsRoCE $true -RemoteIpAddress xxx.xxx.xxx.xxx -PathToDiskspd xxxxx -VfIndex xx

6. Link til download

Har du kommentarer, spørgsmål eller forslag? Kontakt os på WinServerBlogs@dell.com

Article Properties

Affected Product

PowerEdge, Microsoft Windows Server 2019

Last Published Date

11 Jul 2024

Version

8

Article Type

How To