Slik konfigurerer du gjeste-RDMA på Windows Server

Summary: Denne artikkelen forklarer hvordan du konfigurerer gjeste-RDMA på Windows Server.

Instructions

Innholdsfortegnelse

-

Introduksjon av RDMA (direkte minnetilgang via fjerntilkobling)

-

Laboratoriemiljø

-

Maskinvarekonfigurasjon

-

Konfigurere gjeste-RDMA

-

PowerShell-cmdleter

-

Nedlastingskoblinger

1. Introduksjon av RDMA (direkte minnetilgang via fjerntilkobling)

Remote Direct Memory Access (RDMA) er en flott teknologi som gjør det mulig for datamaskiner å overføre data over nettverket uten å involvere CPU- eller OS-ressurser fra de involverte vertene (databehandling/lagring), forbedre gjennomstrømming og ytelse, redusere ventetid og CPU-overhead.Det er to populære RDMA-implementeringer i dag:

RoCE-transport

: UDP/IP (RoCE v2)

– stol på DCB (Data Center Bridging)

iWarp

– underliggende nettverk: TCP/IP

– TCP gir flytkontroll og håndtering av overbelastning

RoCE er svært avhengig av DCB-konfigurasjon som ETS (Enhanced Transmission Service) og PFC (Priority Flow Control), noe som kan bli et problem hvis nettverkssvitsjer ikke er riktig konfigurert. iWARP krever ingen svitsjkonfigurasjon.

Microsoft begynte å støtte RDMA på Windows Server 2012 og la til nye funksjoner i de senere Windows Server OS-ene. Én funksjon som er tilgjengelig på Microsofts nyeste operativsystem, Windows Server 2019, er muligheten for å presentere RDMA for gjesteoperativsystemet (virtuell maskin). Dette gjør at gjesten kan ha samme tilgang med kort ventetid til nettverkslagring som den opprinnelige verten, noe som reduserer CPU-forbruket og forbedrer gjennomstrømming/ytelse direkte i den virtuelle maskinen.

Dell EMC gir gode alternativer for 25 Gbps RDMA, for eksempel Cavium QLogic FastLinQ 41262 Dual Port 25 GbE SFP28 (iWarp/RoCE) og Mellanox ConnectX-4 Lx 25Gbps RDMA (RoCE). Dette eksemplet bruker Mellanox ConnectX-4 Lx RDMA (RoCEv2-modus) for å demonstrere funksjonen for gjeste-RDMA.

2.Laboratoriemiljø

Servere: 2 x Dell EMC R7425 (AMD Epyc 7551 32-kjerners prosessor), 256 GB minne, Mellanox ConnectX-4 Lx fullstendig oppdatert (BIOS, fastvare, drivere og operativsystem)Roller/funksjoner installert: Hyper-V, DCB, failover-klynging, S2D-svitsj

: Dell EMC S5048F-ON – MGMT VLAN 2, SMB VLAN 15

3. Maskinvarekonfigurasjon

1. Start serverne på nytt, og gå til systemoppsettet (Trykk på F2 under POST).

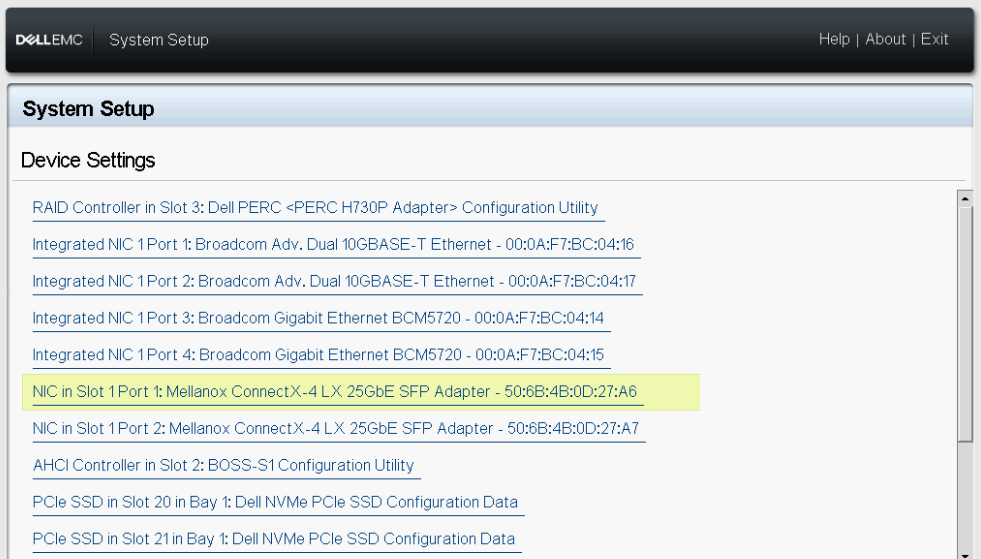

2. Velg Device Settings (Enhetsinnstillinger).

Figur 1 – BIOS-enhetsinnstillinger

3. Velg NIC i spor 1 Port 1 – Mellanox

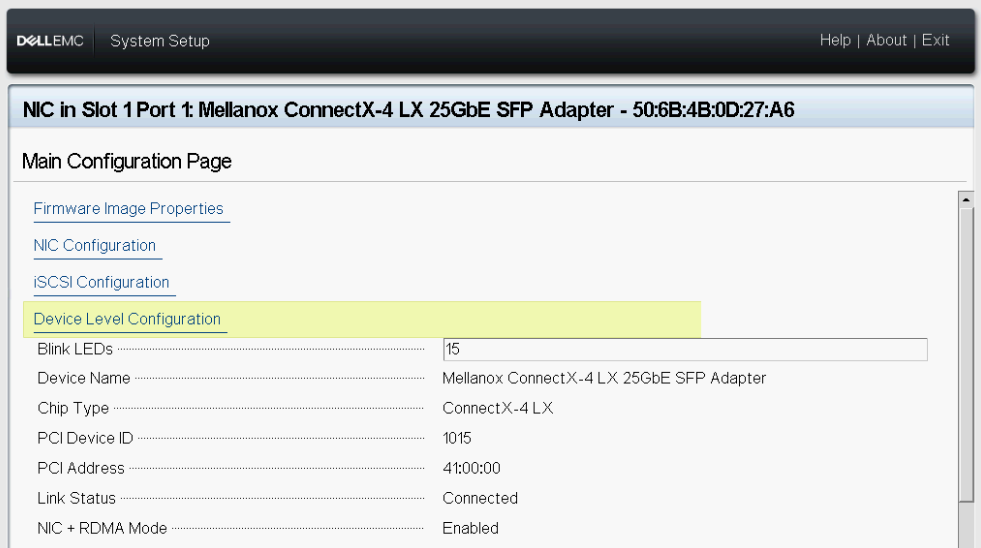

Figur 2 – Mellanox spor 1 Port 1 Enhetsinnstillinger

Figur 2 – Mellanox spor 1 Port 1 Enhetsinnstillinger

4. Gå til konfigurasjon

på enhetsnivå Figur 3 – konfigurasjon

på enhetsnivå Figur 3 – konfigurasjon

på enhetsnivå 5. Velg SR-IOV i virtualiseringsmodus.

Figur 4 – SR-IOV-innstilling

6. Gjenta trinnene ovenfor på NIC i spor 1 Port 2 – Mellanox.

Figur 5 – Enhetsinnstillinger

for Mellanox-spor 1 port 2 7. Gå tilbake til hovedmenyen i systemoppsettet, og velg deretter System-BIOS.

Figur 6 – system-BIOS

8. Velg Integrerte enheter.

Figur 7 – integrerte BIOS-enheter

9. Aktiver alternativet Aktiver global SR-IOV.

Figur 8 - SR-IOV Global

10. Lagre konfigurasjonen, og start serveren på nytt.

4. Konfigurere gjeste-RDMA

1. Installer Windows Server 2019+

2. Installer Hyper-V-rollen og Data Center Bridging-funksjonen (DCB).

3. Konfigurer QoS (Quality-of-Service), DCB, PFC, ETS. Kontroller at konfigurasjonen for serverens nettverkskort og QoS samsvarer med svitsjkonfigurasjonen.

4. Konfigurere Hyper-V SET (Switch Embedded Team).

Figur 9 – vSwitch-konfigurasjon

5. Test RDMA-kommunikasjonen mellom de fysiske serverne før du konfigurerer de virtuelle maskinene. Last ned Microsoft Diskspd- og Microsoft Test-RDMA PowerShell-skriptet. Fortsett bare med trinnene nedenfor hvis kommunikasjonen fungerer som den skal. Kontroller svitsjkonfigurasjonen og/eller DCB-innstillingene på verten.

Figur 10 - Test-RDMA fysiske verter

6. Kontroller om SR-IOV er aktivert på RDMA-adapterne på begge serverne.

Figur 11 – SR-IOV aktivert

7. Opprett to virtuelle Gen 2-maskiner (gjesteoperativsystem), én på hver server, og installer deretter Windows Server 2019. I dette scenariet opprettes et gjesteoperativsystem med to vNIC-er, én for MGMT-trafikk (VLAN 2) og én for SMB-trafikk (VLAN 15).

Figur 12 – Vert for gjesteoperativsystem-nettverkskonfigurasjon R7425-01

Figur 13 – Virtual Machine Network Configuration Host R7425-02

8. Slå av de virtuelle maskinene.

9. Aktiver SR-IOV og RDMA på gjesteoperativsystemet.

Figur 14 – Aktiver SR-IOV/RDMA på gjesteoperativsystemer

10. Start de virtuelle maskinene, og åpne deretter Device Manager (Enhetsadministrator). Mellanox Virtual Function (VF) skal være oppført under Nettverksadaptere. VF vises ikke som et vanlig nettverkskort i Network Connections (Nettverkstilkoblinger), som vist i figur 15.

Figur 15 – Device Manager (Enhetsadministrator) og Network Connections (Nettverkstilkoblinger) i gjesteoperativsystem

Figur 16 – Aktiver RDMA på SMB vNIC

12. Test gjeste-RDMA.

Merk: Det er viktig å spesifisere IfIndex (vNIC Interface Index) og VfIndex (Mellanox VF Interface Index).

Merk: Det er viktig å spesifisere IfIndex (vNIC Interface Index) og VfIndex (Mellanox VF Interface Index).

Figur 17 – Test-RDMA Guest OS

5. PowerShell-cmdleter

#Create new virtual switch with SRIOV option enabled New-VMSwitch -Name xxxx -NetadapterName xxxx,xxxx -AllowManagementOS $true -EnableEmbeddedTeaming $true -EnableIov $true #Verify if SRIOV is enabled on physical adapter Get-NetAdapterSriov -Name xxxx #Get VM network configuration Get-VM -Name xxxx| Get-VMNetworkAdapter #Get VM network VLAN configuration Get-VM -Name | Get-VMNetworkAdapterVlan #Set VM SRIO and RDMA on Virtual Machine(Guest OS) vNIC Get-VM -Name xxxx | Set-VMNetworkAdapter -Name xxx -IovWeight 100 -IoVQueuePairsRequested 2 Get-VM -Name xxxx | Set-VMNetworkAdapterRdma -Name xxx -RdmaWeight 100 #Enable RDMA on NetAdapter Enable-NetAdapterRdma -Name xxxx #Test-Rdma Physical Host .\Test-Rdma.ps1 -IfIndex xx -IsRoCE $true -RemoteIpAddress xxx.xxx.xxx.xxx -PathToDiskspd xxxxx #Test-Rdma Virtual Machine (Guest OS) .\Test-Rdma.ps1 -IfIndex xx -IsRoCE $true -RemoteIpAddress xxx.xxx.xxx.xxx -PathToDiskspd xxxxx -VfIndex xx

6. Nedlastingskoblinger

Har du kommentarer, spørsmål eller forslag? Kontakt oss på WinServerBlogs@dell.com