Ahora hay 14 razones por las que los servidores de un solo socket podrían ser los más importantes en el futuro. El pasado mes de abril publiqué un artículo en The Next Platform titulado Why Single Socket Servers could rule the future (Por qué los servidores con un solo socket podrían gobernar el futuro), y pensé en ofrecer una visión actualizada, ya que hay nuevos productos que han llegado al mercado y hemos tenido feedback de muchos clientes sobre este tema:

Os muestro una lista con los 10 puntos principales más importantes:

- Más que suficientes núcleos por socket y tendencia más alta

- Sustitución de servidores 2S infrautilizados

- Mayor facilidad para acceder a los canales binarios de la memoria y, por tanto, a los límites de la memoria binaria (128, 256, 512…)

- Menor coste para el clustering de resiliencia (menos CPU/memoria….)

- Mejor coste de licencias de software para algunos modelos

- Evite el golpe de rendimiento de NUMA – IO y Memoria

- Densidad de potencia en el centro de datos para evitar puntos calientes

- Reproducir los pines NUMA para más canales: DDRx o PCIe o futuros buses (CxL, Gen-Z)

- Permite una mejor conexión de la unidad directa NVMe sin interruptores PCIe

- Estudio de Gartner que lo avala: (https://www.gartner.com/doc/reprints?id=1-680TWAA&ct=190212&st=sb).

TAMBIÉN TE PUEDE INTERESAR: ¿Rack o Torre? El servidor para empresas pequeñas

TAMBIEN TE PUEDE INTERESAR: Las 5 cosas que tienes que considerar si vas a comprar tu primer servidor

Partiendo de esta premisa, he tenido muchas conversaciones con clientes y gracias a su feedback he obtenido información adicional. Además, ahora tenemos un rico procesador de un solo socket que puede habilitar estos principios: El procesador EPYC de segunda generación de AMD con nombre en código ROME.

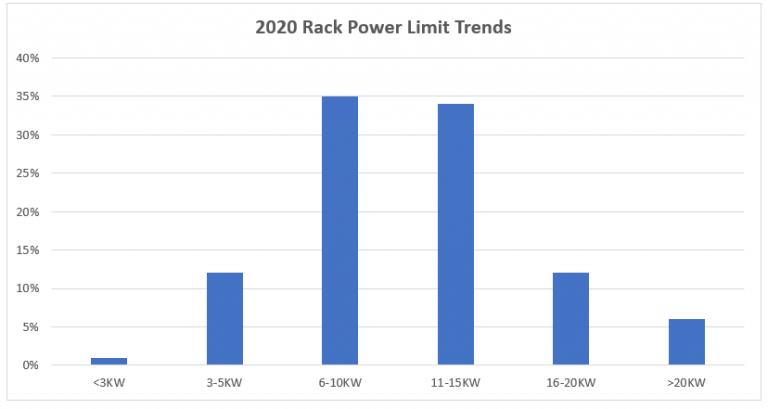

¿Qué más hemos aprendido? En primer lugar, desde el punto de vista del cliente, los límites de potencia en el rack hoy en día no cambian fundamentalmente – o al menos no cambian muy rápido. Desde una perspectiva mundial que estudia a los clientes, las tendencias de la potencia de rack se muestran a continuación:

Estas cifras son alarmantes si se tiene en cuenta la dirección de las CPU y las GPU que están impulsando 300 vatios y más en el futuro. Aunque no todo el mundo adopta las CPU/GPU de gama alta, cuando estos dispositivos se desplazan hacia una mayor potencia, eso hace que el punto dulce de potencia se incremente debido a la distribución normal. Entonces, si se tiene en cuenta la dirección de la DDR5 y el número de canales DDR, la generación 4/5 del PCIe y el número de carriles, Ethernet 100G+ y la creciente adopción de NVMe, el problema de la alimentación del rack vuelve a aparecer. Los clientes se enfrentan a algunas decisiones críticas: (1) aceptar el futuro aumento de la energía del servidor y reducir el número de servidores por rack o (2) cambiar a servidores de menor energía para mantener el número de nodos de servidor o (3) aumentar la energía del rack del centro de datos y el enfriamiento que lo acompaña o (4) moverse a la nube pública – eso por sí solo no resolverá el problema de la energía del rack que se está gestando ya que ellos también tienen que lidiar con el creciente problema de la energía del rack. Con el aumento de la demanda computacional impulsada por los datos y habilitada por AI/ML/DL esta situación no va a mejorar. La adopción de servidores de un solo socket 1U y 2U puede reducir enormemente la energía por nodo y así ayudar a quitar la presión del problema de la energía del rack.

Los problemas de alimentación no sólo afectan al centro de datos, sino que están presentes en el borde. A medida que se crean más datos en el borde por el número cada vez mayor de dispositivos de IoT y IIoT, necesitaremos una computación capaz de analizar y filtrar los datos antes de que los resultados se envíen al Data Center. Por todas las razones en los párrafos anteriores y posteriores, los ordenadores de borde se beneficiarán de servidores ricos de un solo socket. Estos servidores deberán ser altamente eficientes en el uso de la energía, proporcionar el rendimiento necesario para manejar los datos en tiempo real y, en algunos casos, ser compatibles con arquitecturas específicas del dominio (DSA) como las GPU, las FPGAs y los aceleradores AI para manejar las cargas de trabajo asociadas con el IoT/IIoT. Estas cargas de trabajo incluyen la recopilación y clasificación de datos, el filtrado de datos, el análisis de datos, los sistemas de control para la fabricación y la IA/ML/DL. Los servidores de borde más populares se diferencian de sus homólogos de DC por ser más pequeños. En muchas situaciones, los servidores de borde también necesitan ser reforzados para operar en temperaturas prolongadas y condiciones ambientales severas. Los servidores de centro de datos normalmente soportan un rango de temperatura máximo de 25-35C. Mientras que los servidores de borde necesitan ser diseñados para operar en ambientes de almacén y fábrica (temperatura máxima de 25-55C) y en ambientes severos (temperatura máxima de 55-70C). Cuando se reduce la complejidad de cálculo de 2 procesadores y 24-32 DIMM a 1 procesador con 12-16 DIMM, se puede reinventar el aspecto de un servidor y satisfacer las necesidades del borde.

Otra observación y preocupación interesante planteada por los clientes es sobre el coste global de la plataforma. En los últimos años el precio de la CPU y la DRAM ha crecido. Muchos clientes desean la paridad de costes generación a generación y los clientes esperan obtener un rendimiento superior en un Y% – la Ley de Moore en acción. Pero a medida que las CPUs crecieron en capacidad (núcleos y coste) añadieron más canales DDR que fueron necesarios para alimentar los núcleos adicionales. Para obtener el mejor rendimiento se debe llenar 1 DIMM por canal, lo que obligó a los clientes a instalar más memoria. A medida que los precios de la CPU aumentaron con la necesidad de DRAM adicional, se rompió el aspecto de la paridad de costos de generación a generación. En viene el servidor rico de 1-socket y ahora a nivel de sistema usted puede comprar menos DIMMs y CPUs – ahorrando costo y energía a nivel de nodo sin tener que compensar el rendimiento.

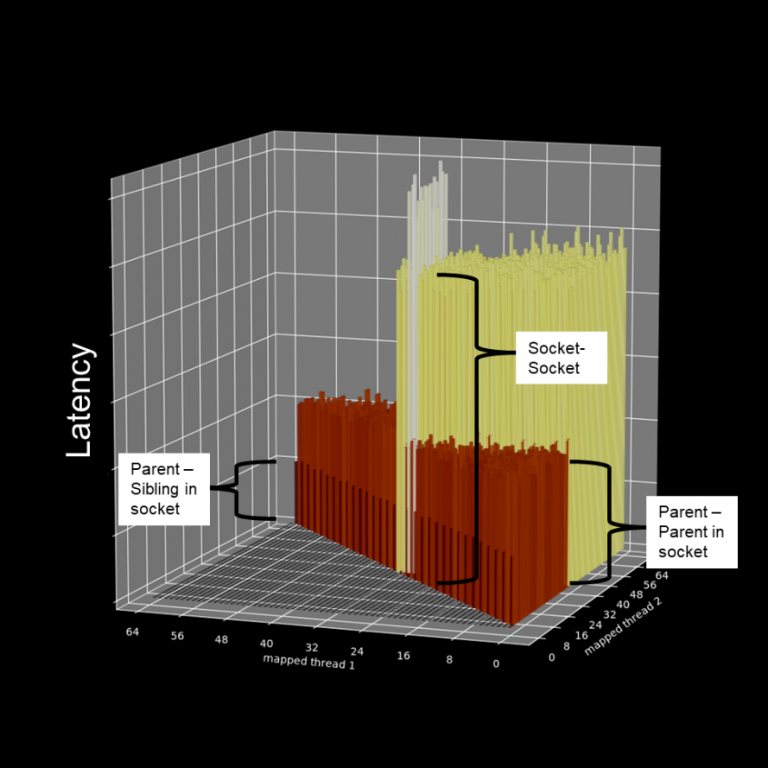

El último punto que los clientes han compartido conmigo es sobre la reducción de la complejidad. Muchos dijeron que habían pasado semanas persiguiendo lo que se creía que era un problema de red cuando se trataba del desafío IO NUMA de 2 sockets que resalté en el último artículo. Al adoptar servidores de 1 socket, los compradores pueden reducir la complejidad de las aplicaciones/cargas de trabajo al no convertir a los desarrolladores de aplicaciones y de TI en expertos en IO y memoria NUMA. En el último documento mostré el impacto de IO NUMA en el ancho de banda y la latencia (hasta un 35% de degradación del ancho de banda y un 75% de aumento de la latencia).

A continuación se muestra una vista de la memoria NUMA en un servidor estándar de 2 sockets donde empezamos con core0 y hacemos un barrido a través de todos los núcleos midiendo los datos que comparten la latencia. A continuación, vamos al core1 y volvemos a hacer un barrido a través de todos los núcleos, y así sucesivamente hasta que se hayan medido todos los pares de núcleos. La barra más baja es el intercambio L2/L1 de un padre a su núcleo HT hermano, el siguiente nivel arriba son todos los núcleos dentro de un socket compartiendo L3. El siguiente nivel arriba es a través de los sockets. Y para ser honesto, los pocos que son los más altos no hemos concluido qué es lo que está causando eso todavía – pero creo que entiendes el punto – es complicado y puede causar variabilidad.

Al utilizar un solo socket, los administradores y desarrolladores de TI pueden ignorar el hecho de tener que convertirse en expertos en mapeo de afinidades, aplicación de fijación a núcleos calientes, control NUMA, etc., lo que conduce a una reducción de la complejidad en todos los ámbitos. Al final del día, esto ayuda a permitir el determinismo de la aplicación, que se está convirtiendo en algo crítico en el centro de datos definido por el software para cosas como SDS, SDN, Edge Computing, CDN, NFV, etc.

Entonces, ¿qué nuevas ventajas de los servidores de 1-socket hemos descubierto?

- Evitar (o retrasar) los retos de alimentación del rack que se avecinan, lo que podría reducir el número de servidores por rack.

- Prepárese para sus necesidades de Edge Computing.

- Mejor estructura de costes de los servidores para permitir la generación de paridad con la generación.

- Reducción de la complejidad al no hacer que los administradores de TI y los desarrolladores de aplicaciones se conviertan en expertos en IO y memoria NUMA, a la vez que se evita que el administrador de red persiga a los fantasmas.

Para apoyarte mejor en tu viaje de transformación digital, actualizamos nuestro portafolio PowerEdge de servidores optimizados de 1-socket utilizando las últimas y mejores características de la CPU AMD ROME. Servidor en rack PowerEdge R6515 y el servidor en rack PowerEdge R7515 como se muestra a continuación.

Si tiene alguna pregunta, quiere profundizar o quiere entender la familia de servidores optimizados de 1 socket de Dell, puedes escribir un comentario directamente en este artículo, y nos pondremos en contacto contigo inmediantamente.

Para obtener más información sobre los servidores PowerEdge, incluidos los R6515 y R7515, visite la página de servidores PowerEdge o únase a la conversación en Twitter.